Spis treści

- Od czego zależy kolejność wyników wyszukiwania?

- Co składa się na proces pozycjonowania strony?

Pozycjonowanie stron internetowych – co to jest i jak to robić w 2024

Pozycjonowanie strony internetowej to zestaw metod i działań, mających na celu manipulację wynikami wyszukiwania w wyszukiwarkach internetowych w celu pozyskania z nich ruchu na stronę internetową. Pozycjonowanie stron internetowych to najtańszy (w perspektywie czasu) i najefektywniejszy sposób pozyskiwania ruchu do strony, np. do sklepu internetowego. Dzięki obecności w wyszukiwarce, docieramy do użytkowników na każdym etapie ich “cyklu życia”: od pytań i problemów, przez poszukiwanie produktu czy usługi oraz ich dostawcy, sprawdzanie opinii, aż do zakupu.

W działaniach dla naszych klientów pozycjonowanie stron wykorzystujemy do:

Główne elementy nasze strategii pozycjonowania opierają się o 4 filary: content (treści), link building (pozyskiwanie linków), techniczna optymalizacja (praca z kodem strony). Całość napędzamy technologią i sztuczną inteligencją.

Pozycjonowanie stron internetowych to proces optymalizacji strony dla wyszukiwarek internetowych z celem zwiększenia jej widoczności w organicznych (niepłatnych) wynikach wyszukiwania. Głównym celem jest poprawa pozycji strony internetowej w wynikach wyszukiwania dla określonych słów kluczowych, co z kolei ma przyczynić się do zwiększenia ruchu na stronie.

Na czym polega pozycjonowanie stron?

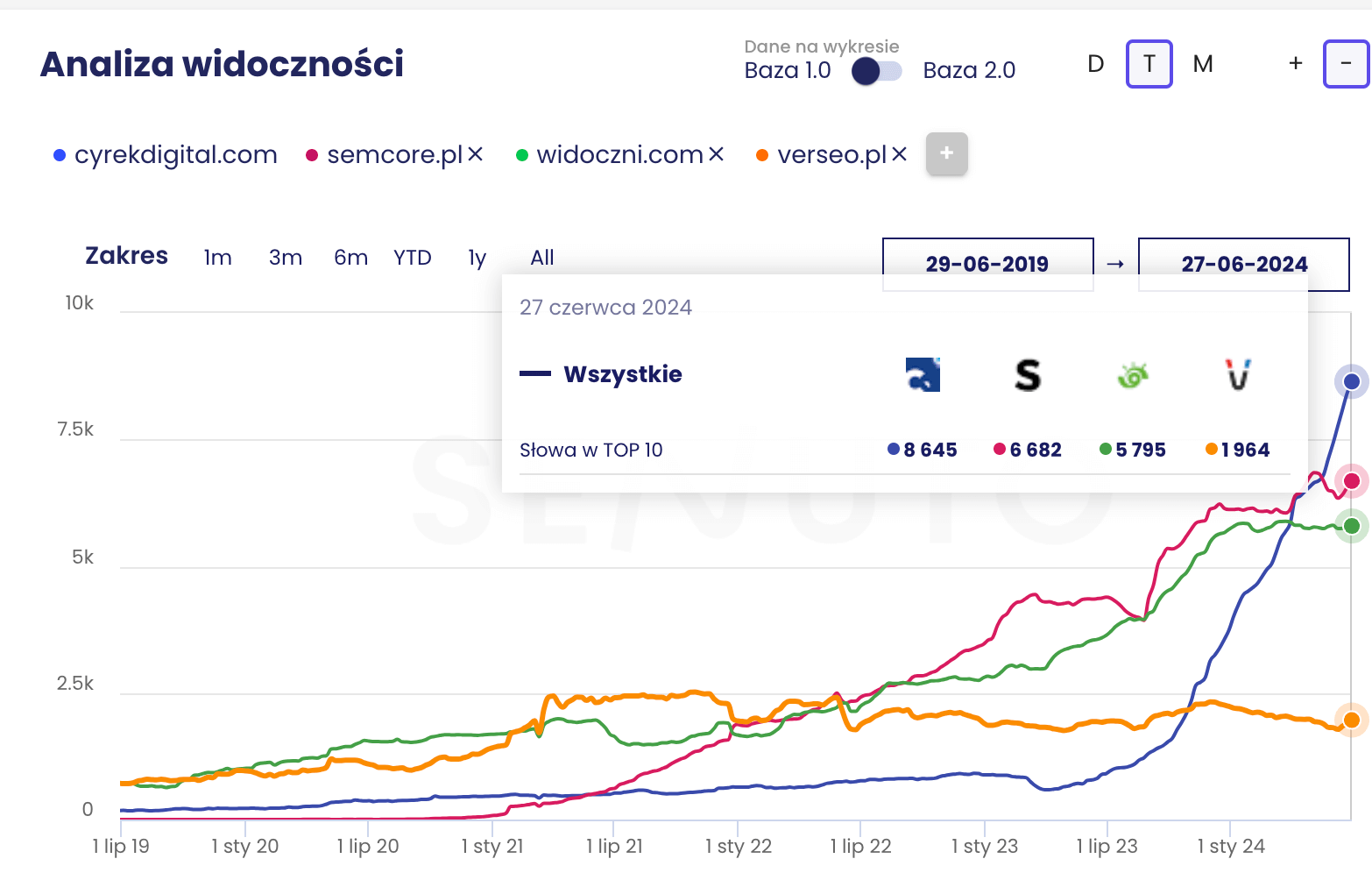

Dzięki czemu jesteśmy w stanie osiągać lepsze wyniki w znacznie krótszym czasie, a poniżej zobaczysz jak wykorzystaliśmy działania budowania widoczności organicznej dla naszej strony w porównaniu do stron innych agencji marketingowych w Polsce, gdzie w czasie 12 miesięcy zbudowaliśmy widoczność na którzy inni pracowali od trzech do pięciu lat.

Zastanawiasz się jaką agencje wybrać? Nasze umiejętności i doświadczenie wykorzystaliśmy opracowywując powtarzalny proces pozycjonowania i przetestowaliśmy go na naszym serwisie. Dzięki czemu staliśmy się liderem widoczności wśród polskich agencji marketingowych z ruchem przekraczającym 1 000 000 sesji rocznie oraz blisko 10 000 frazami na pierwszej stronie wyników wyszukiwania Google.

W poniższym artykule opowiemy m.in. o tym, co wpływa na pozycjonowanie stron internetowych i o co musisz zadbać, aby dojść do pierwszej strony w Google ze swoją domeną.

Od czego zależy kolejność wyników wyszukiwania?

Nie ma jednej prawidłowej odpowiedzi na to pytanie, może z wyjątkiem: “to zależy”. Z pewnością możemy jednak stwierdzić, że czynniki rankingowe przekładają się na pojawianie się strony (lub nie) w wynikach wyszukiwania.

Powszechnie uważa się, że istnieją setki czynników rankingowych, wpływających na kolejność w wynikach wyszukiwania. Czynniki te możemy podzielić na dwie grupy: on-site i off-site. Do najważniejszych należą:

- budowa i struktura strony, jakość i optymalizacja kodu (on-site),

- jakość treści i jej optymalizacja pod kątem wyszukiwarki (on-site),

- dostosowanie do urządzeń mobilnych (on-site),

- szybkość ładowania strony (on-site),

- domeny linkujące do strony, ich ogólna jakość, tematyczne powiązanie ze stroną, zastosowane anchor teksty oraz ilość odnośników (off-site),

- zachowanie użytkowników na stronie – dwell time, bounce rate itd. (off-site).

Można powiedzieć, że jeśli chcemy, aby nasza strona była dobrze oceniana przez wyszukiwarkę Google, musi mieć zoptymalizowany kod HTML, wciągającą treść oraz być popularna (inne rzetelne strony internetowe do niej linkują).

Informacje te są zbierane i agregowane przez tzw. crawlery (znane także jako roboty lub pająki) Google – niewielkie programy, stale przemierzające sieć przy pomocy hiperlinków, w celu tworzenia tzw. indeksu Google – “dokumentu”, określającego na jakiej pozycji wyświetlić jaką stronę na dane zapytanie.

Co składa się na proces pozycjonowania strony?

Pozycjonowanie strony to proces długotrwały. Jeśli raz się już rozpocznie działania SEO, trzeba to robić stale. W przeciwnym razie, wszystkie uzyskane efekty mogą szybko przeminąć. Mimo to, ruch organiczny to dla wielu stron internetowych najtańszy (w przeliczeniu na konwersje) i najbardziej efektywny rodzaj ruchu.

Pomimo faktu, że proces optymalizacji SEO nie ma końca, powinien mieć on sensowny początek. Od czego zacząć skuteczne pozycjonowanie strony internetowej?

Analiza stron konkurencji w wynikach organicznych

Wszystkie działania marketingowe powinny zaczynać się od analizy konkurencji i rynku oraz skrupulatnego zaplanowania działań w oparciu o cele. Tak samo jest z SEO.

W każdej branży i niszy są firmy dominujące – liderzy. Jeśli dobrze się im przyjrzysz, z pewnością zauważysz w jaki sposób pozyskują ruch, jakie stosują taktyki, jakie są ich słabe i mocne strony. Istnieją bezpłatne serwisy (np. Similarweb), gdzie oprócz źródeł (kanałów) ruchu danej domeny, poznamy estymacje (przewidywaną wielkość) ruchu. Robiąc analizę konkurencji SEO należy jednak pamiętać, że dane te nie są nigdy zbyt dokładne. Bardziej wiarygodne informacje o konkurencji możemy uzyskać dzięki płatnym narzędziom SEO.

Poświęcając odpowiedni czas i uwagę lub zlecając taką analizę ekspertom marketingu internetowego, zaoszczędzisz sobie nerwów i kosztów w przyszłości. Pozwoli Ci to uniknąć błędów, które mógłbyś popełnić, nie weryfikując działań konkurencji.

Rozległa wiedza o konkurencji i ich działaniach jest niezbędna dla stworzenia strategii SEO. Będziesz jej potrzebować, żeby Twoje działania były spójne, stałe i pozwoliły Ci osiągnąć stawiane cele. Strategia pozycjonowania powinna opierać się o odpowiednio dobrane słowa kluczowe, związane bezpośrednio z Twoim biznesem. To za ich pomocą użytkownicy Google będą szukać Twoich produktów i usług (realizować intencję wyszukiwania).

Sprawdź, jakie frazy przynoszą ruch Twoim konkurentom

Gdzie znaleźć frazy kluczowe? Analizując zawartość (content), opisy meta title stron Twoich konkurentów oraz anchor teksty ich linków wewnętrznych, dowiesz się, na jakie frazy chcą być widoczni. Zweryfikuj, czy mają one sens również dla Ciebie – jeśli tak, dodaj je do swojej listy słów kluczowych.

Wykorzystaj narzędzia do analizy słów kluczowych

Jeśli chcesz działać bezkosztowo, możesz wykorzystać planer słów kluczowych – na przykład ten, oferowany przez Google – natychmiast poznasz setki fraz kluczowych, które mogą przynieść ruch na Twoją stronę. Niestety – bez aktywnego wydawania budżetów w Google Ads, dane te będą bardzo niedokładne (w formie bardzo rozległych zakresów).

Możesz również skorzystać z jednego z zewnętrznych, płatnych narzędzi SEO, np. Ahrefs, Majestic czy Senuto. Dzięki swoim modułom do keyword researchu nie tylko dostarczą Ci aktualnych informacji o potencjale (Search Volume, SV) danych fraz kluczowych, lecz także podpowiedzą nowe słowa, powiązane z analizowanymi.

Wykorzystaj podpowiedzi Google w pozycjonowaniu stron www

Również sama wyszukiwarka Google jest w stanie dostarczyć nam informacji o nowych słowach kluczowych. W przypadku wielu popularnych zapytań, na samym dole strony wyników wyszukiwania znajdziemy sekcję “Podobne wyszukiwania”:

Nie dostarczy ona co prawda informacji o potencjale wyszukań danej frazy, ale być może pozwoli odszukać jeszcze “niezagospodarowane” słowa kluczowe, znajdujące się w Twojej niszy.

Dobierz frazy, wykorzystując własne doświadczenie

Nikt inny nie będzie wiedział lepiej niż Ty, jakie usługi oferujesz, jakie produkty sprzedajesz i co chcą o nich wiedzieć potencjalni klienci.

Wykorzystaj swoją wiedzę do wstępnego określenia bazy fraz kluczowych – myśl jak Twój klient. Jest to szczególnie ważne w przypadku biznesów niszowych, gdzie narzędzia mogą nie mieć wystarczających danych do sensownej analizy.

Plan jak zdobyć najwyższe pozycje, czyli strategia SEO

Wiedza o działaniach konkurencji oraz lista słów kluczowych to jeszcze nie wszystko, o czym powinieneś pomyśleć na etapie tworzenia strategii pozycjonowania strony. Ostateczna strategia SEO, która będzie długoterminowo kształtowała Twoje działania w obszarze marketingu w wyszukiwarkach powinna zawierać informacje, które pozwolą określić kiedy możesz otworzyć szampana (cele SEO takie jak ruch, czy widoczność na określone frazy) i dawać obraz ile te działania będą kosztować.

Aby osiągać rezultaty, musisz wiedzieć jak je mierzyć

Na samym początku zdecydowanie warto zastanowić się nad tym, co konkretnie chcemy osiągnąć za pomocą działań SEO oraz jak mamy zamiar te osiągnięcia mierzyć. Innymi słowy, potrzebujemy celów oraz KPI.

Cele powinny być możliwie, konkretne i policzalne, jak np.: zwiększenie ruchu organicznego o x%, osiągnięcie pozycji w top 10 na konkretne słowa kluczowe, zmniejszenie współczynnika odrzuceń o x% itd.

Najczęściej przyjmowanymi kategoriam w SEO KPI są: ruch organiczny, czas spędzany na stronie, współczynnik odrzuceń i liczba stron na wizytę (najczęściej mierzone przy pomocy Google Analytics). W pozycjonowaniu sklepu internetowego najważniejszymi kategoriami będą oczywiście konwersja i sprzedaży.

Oprócz planu potrzebujesz pieniędzy

Pomimo tego, że SEO jest procesem długotrwałym, to już na etapie strategii zdecydowanie warto określić wszystkie planowane działania w czasie.

Nie da się ukryć, że przynajmniej część działań, wchodzących w zakres SEO, będzie kosztować – nawet w przypadku optymalizacji SEO na własną rękę. Warto mieć to na uwadze już na etapie strategii pozycjonowania strony i zarezerwować sobie odpowiedni budżet, np. na copywriting, linkbuilding, czy konsultacje z ekspertem.

Architektura informacji, którą pokochają użytkownicy i Googlebot

Struktura Twojej strony internetowej powinna odzwierciedlać schemat dobrej encyklopedii, w której mamy przejrzysty podział na: działy, kategorie, sekcje, artykuły, ryciny itd. Projektując strukturę naszej strony, powinniśmy poruszać się zawsze od informacji najbardziej ogólnych do informacji najbardziej szczegółowych. Jednocześnie, ponieważ nie podlegamy ograniczeniom dwuwymiarowego papieru, powinniśmy zapewnić możliwość szybkiego przejścia na poszczególne podstrony serwisu z jego części ogólnej.

Przy projektowaniu struktury informacji, jednym z naszych celów powinno być takie budowanie nawigacji strony, aby do każdego miejsca w serwisie móc dotrzeć zgodnie z regułą trzech kliknięć (czyli bardzo szybko).

Zaprojektuj strukturę z myślą o użytkownikach i robotach Google jednocześnie

Z pewnością najważniejszymi stronami w serwisie będą dla Ciebie te, na których użytkownik będzie mógł się z Tobą skontaktować, przeczytać o Twojej firmie, czy zobaczyć galerię zdjęć z targów branżowych. Z punktu widzenia SEO, te strony nie mają żadnej wartości. Jeśli przez złe zaprojektowanie struktury serwisu, najważniejszymi stronami są jedne z powyższych (lub, jak najczęściej się zdarza – polityka prywatności), uniemożliwia to stronie rozwinięcie pełni swych możliwości.

W celu uniknięcia tego scenariusza rozrysuj najpierw strukturę strony. Oprzyj się na wcześniej opracowanej liście słów kluczowych, grupując je w zależności od stopnia ogólności i wolumenu wyszukiwania, ale przede wszystkim – kieruj się logiką!

Przykładowo, projektując stronę firmy meblarskiej, która produkuje biurka, stoły i krzesła, struktura mogłaby wyglądać tak:

- Strona główna

- Biurka

- Stoły

- Stoły okrągłe

- Stoły okrągłe drewniane

- Stoły okrągłe szklane

- Stoły prostokątne

- Stoły prostokątne drewniane

- Stoły okrągłe

- Krzesła

- Krzesła do domu

- Krzesła ozdobne

- Krzesła do jadalni

- Krzesła do biura

- Krzesła do domu

- Blog

- Artykuły

- Inspiracje

- Aktualności

Mamy tutaj logiczny podział na “Biurka”, “Stoły” i “Krzesła”. Prawie każda z tych kategorii zawiera w sobie szereg węższych subkategorii, co pozwala robotom Google jasno określić tematykę witryny i współzależności, występujące między jej częściami.

Do każdej projektowanej struktury należy oczywiście dodać jeszcze strony, istotne dla użytkownika (kontakt, regulamin, F.A.Q. itd.) oraz zapewnić prosty sposób na to, aby dotrzeć do tych podstron.

Doświadczenia użytkownika jako czynnik rankingowy

User Experience (doświadczenia użytkownika) to w bardzo dużym skrócie idea budowania danego produktu (UX dotyczy nie tylko stron internetowych) tak, aby osoba z niego korzystająca robiła to w sposób intuicyjny, zgodny z zamiarem i oczekiwaniem projektanta, a jednocześnie, aby produkt spełniał oczekiwania użytkownika.

W przypadku stron internetowych, na dobre standardy UX składają się między innymi:

- przejrzysta i prosta nawigacja,

- treści dopasowane do intencji użytkownika,

- dobrze dobrane elementy funkcjonalne (zapis do newslettera, formularz szybkiego kontaktu, pasek postępu czytania).

Projektowanie stron WWW z dbałością o UX, wpływa na pozycjonowanie stron internetowych w sposób bezpośredni. Dobry “flow” użytkowników w serwisie to zmniejszony współczynnik odrzuceń, dłuższy czas, spędzony na stronie i więcej przejrzanych podstron. To wszystko będzie mieć swoje odbicie w rankingu Google. Odpowiednio zaprojektowana strona jest też po prostu łatwiejsza w obsłudze: user szybko dociera tam, gdzie chce, co zwiększa prawdopodobieństwo konwersji – zyskujesz większą szansę na to, że zwykli użytkownicy zamienią się w potencjalnych klientów.

Tematyczne łączenie stron w ramach wewnętrznego linkowania

Linkowanie wewnętrzne jest istotną częścią on-page SEO. Właściwie zrealizowane umożliwi robotom łatwiejsze przemierzanie, zrozumienie i zaindeksowanie naszej strony.

Część podstron w serwisie zostanie oczywiście automatycznie podlinkowana dzięki właściwie zaprojektowanej nawigacji. Warto jednak również “ułatwić” robotom dotarcie do poszczególnych podstron, zapewniając im wiele możliwych “ścieżek” – linków, np. z postów na blogu.

Trzeba przy tym pamiętać o zasadzie First Link Counts. Mówi ona o tym, że jeśli na jednej stronie użyjemy kilku linków do innej podstrony, Google weźmie pod uwagę tylko pierwsze wystąpienie danego urla, a pozostałe linki zostaną zignorowane. Zadbaj o tematyczne powiązanie treści między linkowanymi podstronami. Łącząc ze sobą przepis na pizze ze podstroną o naprawach silnika w samochodzie nie osiągniesz oczekiwanego rezultatu.

Roboty indeksujące też muszą wiedzieć co w trawie piszczy

Plik robots.txt, który powinien znaleźć się w każdej domenie, to “przejście graniczne” dla pająków Google i innych botów. Zanim bot odwiedzi daną podstronę, musi sprawdzić w tym pliku, czy nie jest ona dla niego zablokowana (jeśli jest – odpuści). W pliku robots.txt można blokować dostęp tylko dla wybranych botów, jak i wybranych podkatalogów, a nawet adresów url, pasujących do określonego wzorca.

Powinniśmy zatem nie tylko zadbać o to, by roboty z łatwością mogły dostać się na te podstrony, na których indeksacji nam zależy, lecz także o to, by nie przedostały się na te, których indeksować nie chcemy lub nie powinniśmy, w trosce o pozycje witryny (będzie to możliwe m.in. dzięki zastosowaniu tagu noindex).

Optymalizacja strony internetowej, czyli techniczna perełka

Posiadając już gotową strategię działań oraz przejrzystą strukturę serwisu, musimy jeszcze zadbać o to, aby jego kod był właściwie zoptymalizowany.

Ale co to właściwie znaczy?

Osiągniemy to (w dużym skrócie):

- pozostawiając w indeksie Google tylko te strony, które mają wymierną wartość dla użytkownika wyszukiwarki,

- ograniczając poruszanie się botów Google tylko do indeksowalnych stron,

- upewniając się, że strony ładują się szybko i nie zawierają dużo zbędnego kodu,

- kompresując kod i grafikę strony, co przyspieszy czas ładowania i jednocześnie zmniejszy ilość miejsca, jaką nasze dane zajmują na serwerach Google.

Można powiedzieć, że optymalizacja pod kątem wyszukiwarek to w dużej mierze poprawa kodu strony w celu zwiększenia szybkości działania i wydajności indeksowania jej przez roboty wyszukiwarek internetowych.

Szybkość ładowania strony, a pozycjonowanie strony internetowej w Google

Według danych Google[1], ponad 53% użytkowników mobilnych opuszcza stronę, jeśli ta nie załaduje się w przeciągu 3 sekund. Im dłuższy czas wczytywania, tym wynik ten będzie gorszy.

Pośrednio wpływa to również na ranking, ponieważ Google zawsze stawia na pierwszym miejscu swoich użytkowników. Wysoki bonce rate wskazuje na niedopasowanie wyniku do intencji wyszukiwania, co może skutkować obniżeniem pozycji.

Google udostępnia bezpłatne narzędzie Page Speed Insights, dzięki któremu przeanalizujemy krytyczne elementy i będziemy mogli wpłynąć na przyspieszenie ładowania strony. Leży to w interesie Google, bo jeśli użytkownik opuści stronę przed jej załadowaniem, to w przypadku zainstalowanych na stronie reklam AdSense, Google na tym nie zarobi.

W Cyrek Digital podczas procesu pozycjonowania stron internetowych, w celu zidentyfikowania elementów, wpływających negatywnie na szybkość ładowania, korzystamy również z GTmetrix, Yslow oraz konsoli deweloperskiej przeglądarki Google Chrome.

Przekierowania a pozycjonowanie stron www

Jednym z najgorszych scenariuszy dla każdej strony internetowej jest przypadek, w którym już uda nam się pozyskać przejście z wyszukiwarki, ale użytkownik trafi na stronę błędu 404 (brak strony docelowej) i opuści serwis.

Taka sytuacja najczęściej ma miejsce po migracjach stron na nowy silnik, optymalizacji URLi, zmianie struktury adresów podstron lub po prostu po usunięciu części treści z serwisu. W każdym z tych przypadków musimy zadbać o to, aby użytkownik znalazł się na innej, nowej podstronie, która odpowiada intencjom jego wyszukiwania. Osiągniemy to, używając przekierowania 301 (przekierowanie permanentne).

Powinniśmy pamiętać o tym, że:

- Przekierowujemy na najbardziej zbliżoną tematycznie podstronę. Jeśli usuwamy produkt ze sklepu, wyślijmy użytkownika na stronę innego, podobnego produktu. Jeśli nie mamy podobnego produktu, zastosujmy przekierowanie na stronę kategorii.

- Unikamy przekierowania na stronę główną. Jeśli stara podstrona generowała ruch z wyników organicznych, to po przekierowaniu jej na stronę główną, możemy być pewni, że po kilkunastu dniach stracimy ten ruch (chyba, że całą treść i optymalizacje podstrony przeniesiemy również na główną stronę serwisu – ale takie sytuacje praktycznie nie mają miejsca).

- Upewniamy się, że przekierowanie jest permanente (301), a nie tymczasowe (302).

- Upewniamy się, że przekierowanie nie generuje łańcucha przekierowań (redirect chain). Oznacza to, że adres, na który przekierowujemy użytkownika, jest adresem ostatecznym. Jeśli w obrębie serwisu występują linki wewnętrzne do stron z przekierowaniem 301, to zadbajmy również o to, aby te linki zaktualizować na adresy docelowe.

Teoretycznie istnieją również przypadki, kiedy przekierowania nie są wskazane. Do (około) 2016 roku powszechnie uważano, że:

- przekierowania 301 powodują utratę ok. 15% mocy podstrony i wpływają negatywnie na pozycjonowanie stron www,

- przekierowania 302 powoduj�ą utratę 100% mocy przekierowania (z definicji są tymczasowe),

- migracja sklepu internetowego lub innej witryny na https szkodzi pozycjom w rankingu, bo sprawia, że każdy adres URL jest przekierowany.

Obecnie Google (poprzez swoich pracowników) zapewnia, że:

- przekierowanie serwisu na wersje https (według zapewnień Johna Muellera) nie powoduje zmian w rankingu Google

- długotrwałe przekierowania 302 są z czasem przez Google uznawane za przekierowania 301 (znów John Mueller),

- przekierowania nie powodują utraty mocy – jak zapewnia Gary Illyes[2].

Z naszych doświadczeń wynika jednak, że ręczna zmiana przekierowań 302 na 301 powoduje duży skok, jeśli chodzi o widoczność strony. Tak samo dzieje się w przypadku eliminacji przekierowań wewnętrznych.

Kod HTML, którego nie powstydzi się żaden webdeveloper

Analiza techniczna strony internetowej pozwala przede wszystkim na solidne przygotowanie się do procesu pozycjonowania stron www. Szczegółowe informacje na temat błędów w kodzie strony internetowej przynosi audyt SEO. Przeprowadzenie audytu pozwala zidentyfikować i sklasyfikować wszystkie problemy, które trafią następnie jako poprawki do programisty.

Audyt rozpoczynamy od przecrawlowania strony, czyli popatrzenia na nią oczami Googlebota. Crawler odwiedza wszystkie podstrony serwisu i gromadzi informacje (m.in) o:

- opisach meta,

- długości tekstu,

- wskazaniach kanonicznych,

- przekierowaniach,

- błędach 404,

- błędach serwerowych,

- powiązaniach między podstronami.

Pozwala to zmapować strukturę strony – dzięki danym, zebranym przez crawler wiemy, które strony powinny być w największym stopniu linkowane wewnętrznie w obrębie całej domeny, dla zwiększenia ich pozycji w wyszukiwarce.

Podczas audytu SEO weryfikujemy poprawność kodu HTML z uwzględnieniem zasady First Link Counts. Poprawiamy te elementy kodu, które powodują przypadkową duplikację treści, np. sortowanie czy filtrowanie – ponieważ źle zaimplementowane, negatywnie wpływają na pozycjonowanie stron www w wynikach wyszukiwania.

Jednym z istotnych elementów audytu SEO jest analiza logów serwerowych. Na tej podstawie jesteśmy w stanie odtworzyć sposób poruszania się robota Google po stronie oraz wydedukować, na co traci więcej czasu niż powinien. Często jesteśmy w stanie zobaczyć, że Googlebot odwiedza adresy URL, które powstały na skutek błędu w kodzie HTML. Wpada wtedy w niekończące się pętle dynamiczne tworzonych adresów www. Ma to miejsce szczególnie w takich elementach serwisu, jak nawigacja czy strony z parametrami.

Chcąc sprawdzić co ma wpływ na pozycję danej strony, spoglądamy również w przeszłość. Często spotykamy się z sytuacjami, gdzie w przeszłości serwis był bardzo dobrze wypozycjonowany, ale pewnego dnia nagle stracił pozycje (i co za tym idzie – cały ruch organiczny). Czasami dzieje się tak w przypadku nałożenia na serwis kary ręcznej lub algorytmicznej, jednak zazwyczaj spadek widoczności serwisu związany jest z:

- nieudaną migracją na nowy silnik strony,

- błędami programistycznymi,

- błędami serwera,

- w ekstremalnych warunkach: braku przedłużeniu domeny, co jest w stanie zniweczyć nawet najlepsze efekty pozycjonowania.

Treści na stronie, które dają wartość

Proces od zaistnienia potrzeby użytkownika, do jej realizacji, poprzez zakup, jest długi. Im więcej razy na tej ścieżce użytkownik odwiedzi Twój serwis, tym większe prawdopodobieństwo, że ostatecznie stanie się klientem.

Google chce dostarczać swoim użytkownikom takich wyników wyszukiwania, które pozwalają podejmować im jak najlepsze decyzje, oparte o autorytet ekspertów. Dlatego tak ważne w procesie pozycjonowania są unikatowe, wysokiej jakości treści informacyjne dającą wymierną wartość użytkownikowi, które są zgodne z intencją użytkownika.

Cztery filary określające jakość strony

Czynniki E-E-A-T, czyli Experience (doświadczenie), Expertise (ekspertyza), Authoritativeness (autorytatywność), Trustworthiness/Trust (wiarygodność/zaufanie) – to zbiór wytycznych, mające ogromny wpływ na wszystkie strony typu YMYL (Your Money Your Life), czyli takie, których tematyka może mieć (choćby niewielki) wpływ na życie, zdrowie i zamożność użytkowników. Jako twórca treści na stronach internetowych, musisz być doświadczonym ekspertem w swojej dziedzinie, bo tylko to gwarantuje, że znajdzie się ona wysoko w wynikach wyszukiwania.

Google chce mieć pewność, że w najważniejszych obszarach promuje tylko strony, publikujące pewne i sprawdzone informacje, a nie fake newsy, dlatego m.in. zatrudnia ponad 10 000 osób, zajmujących się ręczną oceną jakości stron w indeksie. Google udostępniło również specjalny dokument, “Search Quality Evaluator Guidelines”, który szczegółowo opisuje oczekiwania jakościowe, co do stron internetowych.

Kto o nas mówi, czyli linki przychodzące do strony

Dla wielu osób linkbuilding jest najbardziej żmudną częścią procesu pozycjonowania (ja również należę do tej grupy osób), ale jednocześnie pozyskiwanie linków przynosi wymierne rezultaty. Powszechnie wiadomo, że linki stanowią bardzo silny sygnał rankingowy, pod warunkiem, że:

- pochodzą z zaufanych, mocnych domen, o pokrewnej do strony linkowanej tematyce,

- posiadają właściwy anchor tekst,

- linkują z atrybutem dofollow.

Po czym poznać dobry link pozycjonujący? Posłużmy się przykładem:

Przyjmijmy, że najlepsze strony internetowe (zwłaszcza w kontekście E-E-A-T) to strony rządowe, szkół i uczelni wyższych, wydawnictw naukowych, dużych projektów non-profit itd. Pozyskanie z tego typu stron linków do komercyjnego projektu jest niezwykle trudne (niemal niemożliwe) – zatem link z takiej domeny musi być bardzo wartościowy. Jeśli nie ze strony głównej uniwersytetu, to może ze strony wydziału? Bardziej prawdopodobne, ale również do łatwych nie należy (choć mamy na tym polu pewne sukcesy). Dalej weźmy indywidualną podstronę pracownika naukowego na wybranym wydziale. To, co na niej publikuje, zależy już tylko od niego i często nie podlega weryfikacji. Pozyskanie odnośnika z takiej podstrony może być prostsze, ale jednocześnie będzie miało mniejszą wartość.

Taka sama hierarchia ma zastosowanie w przypadku opiniotwórczego medium – np. ogólnopolskiego portalu informacyjnego. Link pozyskany w artykule, pojawiającym się na pierwszej stronie, będzie miał większą wartość, niż w dziale tematycznym. Ten z kolei będzie miał większą wartość od zamieszczonego w dziale z blogami liderów opinii. Serwis może również udostępniać możliwość blogowania każdemu, we własnej subdomenie. Link z takiego bloga będzie miał już minimalną wartość.

Im więcej wartościowych linków, kierujących do domeny, tym wyższa będzie jej pozycja w Google. (Słusznie) minęły już czasy, gdy dało się wypozycjonować stronę za pomocą systemów wymiany linków, zautomatyzowanych narzędzi do pozyskiwania odnośników czy szeptanki na martwych forach. Algorytmy Google skutecznie filtrują spam i nie uwzględniają obecnie takich linków w ustalaniu rankingu domeny.

Zatem jakość, ale jednocześnie niezbędna jest dywersyfikacja. Na co dzień pozyskujemy linki z różnych źródeł, do których przede wszystkim możemy zaliczyć:

- linki z żywych, specjalistycznych forów internetowych (marketing szeptany),

- linki z blogów (wpisy gościnne),

- linki z wysokiej jakości stron zapleczowych,

- linki z artykułów na popularnych, branżowych portalach,

- linki z publikacji medialnych, uzyskane metodami e-PR.

Dobry artykuł, przemawiający do określonej grupy docelowej, wygeneruje duży ruch na stronie – choćby poprzez dystrybucję w mediach społecznościowych. Kluczowa dla link buildingu jest jednak jego promocja wśród wpływowych w danej niszy serwisów. Jeśli publikujemy coś ciekawego, popartego danymi, statystykami i wzbogaconego estetycznymi infografikami, to powinno to zainteresować media do tego stopnia, że będą chciały podzielić się linkiem ze swoimi czytelnikami.

Nadal myślisz, że SEO jest Ci niepotrzebne? Przemyśl to jeszcze raz!

Formularz kontaktowy

Pozycjonowanie stron internetowych

Razem z całym zespołem Cyrek Digital pomagam firmom w cyfrowej transformacji. Specjalizuje się w technicznym SEO. Na działania marketingowe patrzę zawsze przez pryzmat biznesowy.

Oceń tekst

Być może zainteresują Cię: