Spis treści

- Pozycjonowanie stron – definicja

- Jakie są najważniejsze cele pozycjonowania stron internetowych?

- Jak wygląda proces pozycjonowania strony www krok po kroku?

- Jakie znaczenie ma content marketing w pozycjonowaniu stron internetowych?

- Co obejmuje audyt SEO i dlaczego jest nieodzowny w procesie pozycjonowania?

- Jak linkowanie wewnętrzne wpływa na skuteczność pozycjonowania stron?

- Jak długo trwa pozycjonowanie stron internetowych i kiedy można zobaczyć efekty?

- Dlaczego pozycjonowanie stron www powinno być integralną częścią strategii marketingowej?

- Jak pozycjonowanie stron wpływa na rozwój biznesu online?

- Jakie są najczęstsze wyzwania w pozycjonowaniu stron www w 2025 roku?

- Jak pozycjonowanie stron internetowych zmienia się pod wpływem sztucznej inteligencji i nowych technologii?

- Jakie trendy w pozycjonowaniu www będą dominować w najbliższych latach?

- Jak mierzyć efekty pozycjonowania stron internetowych?

- Jakie błędy najczęściej popełniane są w procesie pozycjonowania stron?

Pozycjonowanie stron internetowych – co to jest i jak to robić w 2025?

Pozycjonowanie stron internetowych w 2025 roku stanowi fundamentalny element strategii marketingowej każdego przedsiębiorstwa, które dąży do zwiększenia widoczności strony w wyszukiwarce Google oraz pozyskania potencjalnych klientów poprzez organiczne wyniki wyszukiwania, co ma bezpośredni wpływ na rozwój biznesu online oraz konkurencyjność na rynku cyfrowym. Współczesne pozycjonowanie stron wymaga holistycznego podejścia, które łączy zaawansowane techniki optymalizacji strony z dogłębnym zrozumieniem algorytmów wyszukiwarek oraz potrzeb użytkowników poszukujących konkretnych produktów bądź usług w wyszukiwarce internetowej. Dlaczego skuteczne pozycjonowanie strony internetowej stało się w 2025 roku nie tylko opcją, ale absolutną koniecznością dla każdego biznesu, który planuje długoterminowy sukces w środowisku cyfrowym?

Z tego artykułu dowiesz się m.in.:

- Czym jest pozycjonowanie stron?

- Jakie są najważniejsze cele pozycjonowania stron internetowych?

- Jak wygląda proces pozycjonowania strony www krok po kroku?

- Jakie znaczenie ma content marketing w pozycjonowaniu stron internetowych?

- Co obejmuje audyt SEO i dlaczego jest nieodzowny w procesie pozycjonowania?

- Jak linkowanie wewnętrzne wpływa na skuteczność pozycjonowania stron?

- Jak długo trwa pozycjonowanie stron internetowych i kiedy można zobaczyć efekty?

- Dlaczego pozycjonowanie stron www powinno być integralną częścią strategii marketingowej?

- Jak pozycjonowanie stron wpływa na rozwój biznesu online?

- Jakie są najczęstsze wyzwania w pozycjonowaniu stron www w 2025 roku?

- Jak pozycjonowanie stron internetowych zmienia się pod wpływem AI i nowych technologii?

- Jakie trendy w pozycjonowaniu www będą dominować w najbliższych latach?

- Jak mierzyć efekty pozycjonowania stron internetowych?

- Jakie błędy najczęściej popełniane są w procesie pozycjonowania stron?

Najważniejsze informacje:

- Pozycjonowanie stron internetowych w 2025 roku wymaga kompleksowego podejścia łączącego optymalizację techniczną z wysokiej jakości treścią.

- Skuteczne pozycjonowanie strony internetowej zwiększa widoczność w organicznych wynikach wyszukiwania oraz pozyskuje potencjalnych klientów.

- Proces pozycjonowania strony www obejmuje: audyt SEO, dobór słów kluczowych, optymalizację treści oraz budowanie autorytetu domeny.

- Efekty pozycjonowania stron internetowych są widoczne po 3-6 miesiącach systematycznej pracy.

- Pozycjonowanie powinno być integralną częścią strategii marketingowej każdego biznesu online.

Pozycjonowanie stron – definicja

Pozycjonowanie stron internetowych to kompleksowy proces optymalizacji witryny pod kątem wyszukiwarek, który ma na celu poprawę pozycji strony w wynikach wyszukiwania Google oraz zwiększenie organicznego ruchu na stronie poprzez: strategiczne wykorzystanie słów kluczowych, wysokiej jakości treści oraz technicznych aspektów optymalizacji strony. Skuteczne pozycjonowanie strony internetowej obejmuje szeroki zakres działań, od audytu SEO i analizy konkurencyjnych stron internetowych po stworzenie strategii pozycjonowania uwzględniającej specyfikę branży oraz potrzeby grupy docelowej odbiorców, co przekłada się na zwiększenie widoczności strony internetowej, a także pozyskanie nowych klientów. Jak znaczące zmiany w algorytmach Google w 2025 roku wpływają na konieczność redefinicji tradycyjnych podejść do pozycjonowania stron www oraz optymalizacji Twojej strony?

Pozycjonowanie stron internetowych to strategiczny proces optymalizacji witryny w organicznych wynikach wyszukiwania poprzez kompleksowe działania obejmujące: dobór słów kluczowych, content marketing, linkowanie wewnętrzne oraz optymalizację techniczną, które mają na celu zwiększenie widoczności strony internetowej oraz pozyskanie potencjalnych klientów w wyszukiwarce Google.

Definicja pozycjonowania stron internetowych

Ta definicja podkreśla wielowymiarowy charakter współczesnego pozycjonowania, które wykracza daleko poza proste techniki optymalizacji. W 2025 roku pozycjonowanie stron www stało się nieodzownym elementem strategii marketingowej, bez którego przedsiębiorstwa tracą szanse na dotarcie do swoich potencjalnych klientów w naturalnych wynikach wyszukiwania.

Jakie są najważniejsze cele pozycjonowania stron internetowych?

Współczesne pozycjonowanie stron internetowych służy realizacji strategicznych celów biznesowych, które wykraczają daleko poza proste zwiększenie ruchu na stronie, koncentrując się na budowaniu długoterminowej pozycji konkurencyjnej w wyszukiwarce Google oraz generowaniu wartościowych konwersji z organicznych wyników wyszukiwania. Skuteczne pozycjonowanie strony internetowej musi uwzględniać różnorodne aspekty działalności online, od poprawy widoczności strony po budowanie zaufania i autorytetu marki w oczach potencjalnych klientów poszukujących konkretnych produktów albo usług. Dlaczego tradycyjne podejście do celów pozycjonowania stron www okazuje się niewystarczające w kontekście złożoności współczesnych strategii marketingowych?

- budowanie autorytetu domeny – systematyczne wzmacnianie pozycji witryny w „oczach” algorytmów wyszukiwarek poprzez wysokiej jakości treści oraz naturalne pozyskiwanie linków zewnętrznych,

- generowanie ruchu organicznego – zwiększenie liczby odwiedzin ze strony użytkowników wyszukujących konkretnych fraz kluczowych w wyszukiwarce internetowej,

- optymalizacja konwersji – przekształcanie ruchu organicznego w konkretne działania biznesowe, do jakich zaliczyć należy: zakupy, zapytania czy rejestracje,

- poprawa widoczności lokalnej – zwiększenie pozycji w wynikach wyszukiwania dla zapytań geograficznych istotnych dla działalności przedsiębiorstwa,

- redukcja kosztów pozyskania klientów – zmniejszenie zależności od płatnych form reklamy poprzez budowanie stabilnego źródła ruchu organicznego,

- wzmocnienie konkurencyjności – osiągnięcie przewagi nad konkurencyjnymi stronami internetowymi w najważniejszych dla branży frazach kluczowych,

- zwiększenie rozpoznawalności marki – budowanie świadomości marki poprzez konsekwentną obecność w organicznych wynikach wyszukiwania dla strategicznych zapytań.

Realizacja tych celów w procesie pozycjonowania wymaga strategicznego podejścia oraz cierpliwości, gdyż działa pozycjonowanie stron w dłuższej perspektywie czasowej, a efekty są widoczne stopniowo. Współczesne pozycjonowanie stron www musi uwzględniać nie tylko techniczne aspekty optymalizacji, ale również zmieniające się zachowania użytkowników oraz ewolucję algorytmów wyszukiwarek.

Jak wygląda proces pozycjonowania strony www krok po kroku?

Profesjonalny proces pozycjonowania strony www składa się z sekwencji logicznie powiązanych etapów, które muszą być realizowane systematycznie oraz w odpowiedniej kolejności, aby zapewnić skuteczne pozycjonowanie strony internetowej oraz osiągnięcie zamierzonych efektów pozycjonowania stron internetowych w organicznych wynikach wyszukiwania. Każdy etap procesu pozycjonowania strony www wymaga specjalistycznej wiedzy oraz wykorzystania odpowiednich narzędzi analitycznych, umożliwiających precyzyjne monitorowanie postępów oraz wprowadzanie niezbędnych korekt w strategii pozycjonowania. Jak zaawansowane narzędzia analityczne dostępne w 2025 roku zmieniają tradycyjne podejście do poszczególnych etapów pozycjonowania stron internetowych?

Kompleksowy audyt SEO strony internetowej

Audyt SEO stanowi fundamentalny pierwszy krok w procesie pozycjonowania strony www, obejmujący szczegółową analizę: technicznych aspektów witryny, struktury treści, optymalizacji na urządzeniach mobilnych oraz identyfikację wszystkich czynników, które mogą wpływać na pozycję strony w wynikach wyszukiwania Google. Profesjonalny audyt SEO wykorzystuje zaawansowane narzędzia diagnostyczne oraz Google Search Console do identyfikacji błędów technicznych, problemów z indeksowaniem strony w Google oraz możliwości poprawy wydajności strony internetowej pod kątem wyszukiwarek.

Analiza konkurencji i badanie rynku

Gruntowna analiza strony konkurencji pozwala na zidentyfikowanie strategii pozycjonowania stosowanych przez liderów branży oraz odkrycie nisz rynkowych, które mogą być wykorzystane do osiągnięcia przewagi konkurencyjnej w organicznych wynikach wyszukiwania. Proces analizy obejmuje: badanie fraz kluczowych wykorzystywanych przez konkurencję, analizę ich profili linkowych oraz identyfikację luk w content marketingu, które mogą być wykorzystane do budowania autorytetu własnej witryny.

Strategiczny dobór słów kluczowych

Dobór słów kluczowych stanowi nieodzowny element strategii pozycjonowania strony, wymagający zbalansowania między potencjałem ruchu a poziomem konkurencji dla poszczególnych fraz kluczowych, przy jednoczesnym uwzględnieniu intencji wyszukiwania użytkowników oraz celów biznesowych przedsiębiorstwa. Nowoczesne podejście do doboru słów kluczowych uwzględnia nie tylko frazy główne, ale również długie frazy kluczowe oraz zapytania konwersacyjne, które zyskują na znaczeniu w kontekście rozwoju wyszukiwania głosowego.

Optymalizacja techniczna strony internetowej

Optymalizacja techniczna obejmuje wszystkie aspekty funkcjonowania strony internetowej, wpływające na jej pozycję w wynikach wyszukiwania, włączając: szybkość ładowania, responsywność na urządzeniach mobilnych, strukturę adresów URL, mapy witryny oraz implementację danych strukturalnych. Nazwa domeny ma znaczenie również na etapie planowania widoczności w wyszukiwarce, bo wpływa na czytelność adresu i spójność komunikacji marki. Współczesna optymalizacja techniczna musi uwzględniać również podstawowe wskaźniki wydajności oraz inne czynniki użyteczności, które Google traktuje jako ważne sygnały rankingowe. Współczesna optymalizacja techniczna musi uwzględniać również podstawowe wskaźniki wydajności oraz inne czynniki użyteczności, które Google traktuje jako ważne sygnały rankingowe.

Tworzenie i optymalizacja treści

Content marketing w kontekście pozycjonowania stron internetowych koncentruje się na tworzeniu wartościowych, unikalnych treści, które odpowiadają na pytania użytkowników oraz naturalnie zawierają strategiczne słowa kluczowe, jednocześnie budując autorytet witryny oraz zachęcając do naturalnego linkowania zewnętrznego. Skuteczna strategia treści uwzględnia różnorodne formaty content marketingu, od artykułów eksperckich po materiały multimedialne, zwiększające zaangażowanie użytkowników oraz czas spędzony na stronie.

Budowanie profilu linkowego

Pozyskiwanie linków zewnętrznych pozostaje jednym z najważniejszych czynników rankingowych, wymagającym strategicznego podejścia do budowania naturalnego profilu linkowego poprzez: tworzenie wartościowych treści, budowanie relacji z branżowymi mediami oraz wykorzystywanie możliwości współpracy z innymi witrynami, posiadającymi autorytet. Współczesne linkowanie zewnętrzne koncentruje się na jakości linków oraz ich naturalności, unikając praktyk, które mogą być uznane za manipulacyjne przez algorytmy Google.

Monitorowanie i optymalizacja wyników

Systematyczne monitorowanie efektów pozycjonowania stron internetowych wymaga wykorzystania narzędzi analitycznych, do jakich zaliczają się: Google Search Console, Google Analytics oraz specjalistycznych platform SEO, umożliwiających: śledzenie pozycji w wynikach wyszukiwania, analizę ruchu organicznego oraz identyfikację obszarów wymagających dalszej optymalizacji. Proces monitorowania musi być ciągły oraz obejmować regularne raporty z postępów oraz rekomendacje dotyczące dalszych działań optymalizacyjnych.

Jakie znaczenie ma content marketing w pozycjonowaniu stron internetowych?

Content marketing stanowi jeden z najważniejszych filarów współczesnego pozycjonowania stron internetowych, odgrywając istotną rolę w: budowaniu autorytetu witryny, zwiększaniu zaangażowania użytkowników oraz naturalnym pozyskiwaniu linków zewnętrznych, które bezpośrednio wpływają na pozycję strony w organicznych wynikach wyszukiwania Google. Skuteczny content marketing w kontekście pozycjonowania stron www wykracza daleko poza tradycyjne tworzenie treści, koncentrując się na strategicznym dostarczaniu wartości użytkownikom poprzez: odpowiadanie na ich pytania, rozwiązywanie problemów oraz budowanie zaufania do marki w długoterminowej perspektywie. Jak rewolucja sztucznej inteligencji w 2025 roku wpływa na redefinicję roli content marketingu w strategiach pozycjonowania stron internetowych?

Treści odpowiadają na pytania użytkowników

Wysokiej jakości treści są fundamentem skutecznego pozycjonowania strony internetowej, gdyż Google coraz większy nacisk kładzie na dostarczanie użytkownikom rezultatów, które faktycznie odpowiadają na ich zapytania oraz spełniają ich oczekiwania informacyjne. Content marketing w pozycjonowaniu stron obejmuje nie tylko tworzenie artykułów blogowych, ale również optymalizację opisów produktów w przypadku pozycjonowania sklepów internetowych, tworzenie: przewodników branżowych, studiów przypadków oraz innych formatów treści, które mogą pozycjonować się pod różnorodne frazy kluczowe związane z działalnością przedsiębiorstwa.

Content marketing często przeprowadza klienta przez ścieżkę zakupową

Strategiczny content marketing musi uwzględniać intencje wyszukiwania użytkowników oraz dopasowywać treści do różnych etapów ścieżki zakupowej, od treści informacyjnych dla użytkowników na początku procesu decyzyjnego po szczegółowe opisy produktów dla osób gotowych do zakupu. Skuteczne pozycjonowanie strony www poprzez content marketing wymaga również optymalizacji treści pod kątem wyróżnionych fragmentów oraz innych specjalnych funkcji wyników wyszukiwania, które mogą znacząco zwiększyć widoczność strony internetowej.

Content marketing wzmacnia pozycjonowanie strony internetowej dzięki linkowaniom

Współczesny content marketing w pozycjonowaniu stron internetowych musi również uwzględniać optymalizację dla wyszukiwania głosowego oraz zapytań konwersacyjnych, co wymaga tworzenia treści w formie naturalnego języka oraz strukturyzowania informacji w sposób, ułatwiający algorytmom Google znajdowanie precyzyjnych odpowiedzi na pytania użytkowników. Dodatkowo, content marketing wspiera linkowanie wewnętrzne, umożliwiając tworzenie logicznych połączeń między różnymi sekcjami witryny oraz dystrybucję autorytetu strony w sposób, który wspiera pozycjonowanie najistotniejszych podstron.

Co obejmuje audyt SEO i dlaczego jest nieodzowny w procesie pozycjonowania?

Audyt SEO stanowi kompleksową analizę wszystkich aspektów strony internetowej, które wpływają na jej pozycję w wynikach wyszukiwania Google, umożliwiając: identyfikację problemów technicznych, luk w content marketingu oraz możliwości poprawy skuteczności pozycjonowania strony www poprzez systematyczne działania optymalizacyjne. Profesjonalny audyt SEO wykorzystuje zaawansowane narzędzia analityczne oraz dane z Google Search Console do stworzenia szczegółowej mapy obecnego stanu witryny oraz priorytetyzacji działań Search Engine Optimization, które przyniosą największe korzyści w kontekście poprawy pozycji w wynikach wyszukiwania. Dlaczego regularnie przeprowadzane audyty SEO stały się w 2025 roku koniecznością dla każdej strony internetowej, która dąży do utrzymania konkurencyjnej pozycji w organicznych wynikach wyszukiwania?

| Aspekt audytu SEO | Szczegółowy opis | Główne korzyści | Wyzwania implementacyjne |

|---|---|---|---|

| Analiza techniczna | Kompleksowa ocena infrastruktury technicznej witryny, obejmująca: szybkość ładowania strony, responsywność na urządzeniach mobilnych, strukturę adresów, mapy witryny oraz implementację danych strukturalnych. | – Identyfikacja barier technicznych wpływających na indeksowanie. – Poprawa wydajności strony internetowej. – Zwiększenie kompatybilności z urządzeniami mobilnymi. – Optymalizacja podstawowych wskaźników wydajności. | – Wymagana specjalistyczna wiedza techniczna. – Konieczność współpracy z programistami. – Potencjalne przestoje podczas implementacji. – Koszt wdrożenia zmian technicznych. |

| Audyt treści | Analiza jakości, unikalności oraz optymalizacji wszystkich treści na stronie, w tym ocena: dopasowania do słów kluczowych, struktury nagłówków, opisów oraz długości treści. | – Identyfikacja luk w content marketingu. – Optymalizacja istniejących treści. – Poprawa dopasowania dla fraz kluczowych. – Zwiększenie zaangażowania użytkowników. | – Czasochłonność procesu analizy. – Konieczność przepisania dużej ilości treści. – Zachowanie spójności stylistycznej. – Balansowanie optymalizacji z naturalnością. |

| Analiza słów kluczowych | Ocena obecnego pozycjonowania dla strategicznych fraz kluczowych, identyfikacja nowych możliwości oraz analiza konkurencji w kontekście doboru słów kluczowych. | – Odkrycie nowych szans pozycjonowania. – Optymalizacja istniejącej strategii słów kluczowych. – Lepsze zrozumienie intencji użytkowników. – Zwiększenie ruchu organicznego. | – Konkurencyjność popularnych fraz. – Trudność w prognozowaniu trendów. – Konieczność ciągłego monitorowania. – Balansowanie między różnymi typami słów kluczowych |

| Audyt linkowania | Analiza profilu linków zewnętrznych oraz struktury linkowania wewnętrznego, ocena jakości linków przychodzących oraz identyfikacja możliwości poprawy dystrybucji autorytetu strony w wynikach wyszukiwania. | – Identyfikacja szkodliwych linków. – Optymalizacja linkowania wewnętrznego. – Odkrycie szans na naturalne linkowanie. – Poprawa autorytetu domeny. | – Trudność w ocenie jakości linków. – Ryzyko utraty wartościowych linków. – Czasochłonność procesu dewaluacji. – Budowanie naturalnego profilu linkowego. |

| Analiza konkurencji | Porównawcza analiza strategii pozycjonowania konkurencyjnych stron internetowych, identyfikacja ich mocnych stron oraz luk, które mogą być wykorzystane do osiągnięcia przewagi. | – Analiza porównawcza względem konkurencji. – Identyfikacja najlepszych praktyk. – Odkrycie nisz rynkowych. – Optymalizacja strategii pozycjonowania. | – Dostęp do danych konkurencji. – Interpretacja wyników analizy. – Adaptacja strategii konkurencji. – Różnice w zasobach i możliwościach. |

| Audyt użyteczności | Ocena doświadczeń użytkowników na stronie, analiza współczynników konwersji, czasu spędzanego na stronie oraz innych metryk zaangażowania wpływających na pozycjonowanie. | – Poprawa doświadczeń użytkowników. – Zwiększenie współczynników konwersji. – Optymalizacja ścieżek nawigacji. – Redukcja współczynnika odrzuceń. | – Subiektywność oceny użyteczności. – Konieczność testów z użytkownikami. – Balansowanie między SEO a doświadczeniami użytkowników. – Ciągła optymalizacja interfejsu. |

Systematyczne przeprowadzanie audytów SEO umożliwia przedsiębiorstwom utrzymanie konkurencyjnej pozycji w dynamicznie zmieniającym się środowisku wyszukiwarek internetowych oraz szybkie reagowanie na zmiany w algorytmach Google. Regularny audyt SEO stanowi podstawę dla stworzenia strategii pozycjonowania, która uwzględnia specyficzne potrzeby oraz możliwości danej witryny w kontekście jej branży oraz grupy docelowej odbiorców.

Jak linkowanie wewnętrzne wpływa na skuteczność pozycjonowania stron?

Linkowanie wewnętrzne stanowi jeden z najbardziej niedocenianych, ale jednocześnie niezwykle skutecznych elementów strategii pozycjonowania stron internetowych, umożliwiając efektywną dystrybucję autorytetu strony między poszczególnymi podstronami oraz sygnalizowanie algorytmom Google hierarchii ważności treści w ramach witryny. Strategiczne linkowanie wewnętrzne wspiera pozycjonowanie zarówno głównych stron docelowych, jak i głębszych podstron, które mogą pozycjonować się pod długie frazy kluczowe oraz niszowe zapytania istotne dla pozyskania potencjalnych klientów w organicznych wynikach wyszukiwania. Jak zaawansowane techniki linkowania wewnętrznego mogą radykalnie poprawić skuteczność pozycjonowania strony internetowej bez konieczności pozyskiwania dodatkowych linków zewnętrznych?

Linkowanie wewnętrzne naprowadza algorytm Google na właściwe miejsce

Skuteczne linkowanie wewnętrzne w kontekście pozycjonowania stron www wymaga strategicznego podejścia do tworzenia struktury informacyjnej witryny, która logicznie łączy powiązane tematycznie treści oraz prowadzi użytkowników przez naturalne ścieżki eksploracji content marketingu. Właściwie zaprojektowane linkowanie wewnętrzne pomaga algorytmom Google w zrozumieniu kontekstu oraz tematyki poszczególnych podstron, jednocześnie zwiększając czas spędzony przez użytkowników na stronie oraz redukcję współczynnika odrzuceń, jakie są pozytywnymi sygnałami rankingowymi.

Odpowiednia kotwica umożliwia odnalezienie właściwego elementu tekstu w obrębie strony

Współczesne linkowanie wewnętrzne musi uwzględniać różnorodne formaty treści oraz typy stron w ramach witryny, od artykułów blogowych po strony produktów w przypadku pozycjonowania sklepów internetowych, tworząc spójną sieć połączeń, wspierającą pozycjonowanie strategicznych słów kluczowych na różnych poziomach witryny. Optymalizacja linków wewnętrznych obejmuje również strategiczne wykorzystanie tekstów kotwic, które powinny naturalnie zawierać frazy kluczowe istotne dla docelowych podstron, jednocześnie zachowując naturalność oraz różnorodność w tekstach łączących.

Linkowanie wewnętrzne dzieli tekst na klastry tematyczne, których potrzebuje użytkownik

Nowoczesne podejście do linkowania wewnętrznego wykorzystuje również dane analityczne z Google Search Console oraz narzędzi SEO do identyfikacji stron o wysokim autorytecie, jakie mogą efektywnie przekazywać siłę rankingową do strategicznych podstron wymagających wsparcia w pozycjonowaniu. Dodatkowo, skuteczne linkowanie wewnętrzne wspiera tworzenie tematycznych klastrów treści, pomagających w pozycjonowaniu pod szerokie spektrum powiązanych fraz kluczowych oraz budowaniu autorytetu witryny w konkretnych obszarach tematycznych.

Jak długo trwa pozycjonowanie stron internetowych i kiedy można zobaczyć efekty?

Czas realizacji efektów pozycjonowania stron internetowych zależy od wielu czynników, włączając: konkurencyjność branży, obecny stan optymalizacji strony, jakość implementowanych działań SEO oraz konsekwencję w realizacji strategii pozycjonowania, przy czym pierwsze pozytywne sygnały mogą być widoczne już po 3-4 miesiącach systematycznej pracy, podczas gdy pełne efekty pozycjonowania stron często wymagają 6-12 miesięcy ciągłych działań optymalizacyjnych. Trwa pozycjonowanie stron internetowych różni się znacząco w zależności od ambicji pozycjonowania – czy celem jest poprawa pozycji dla kilku kluczowych fraz, czy kompleksowe pozycjonowanie strony www pod szerokie spektrum słów kluczowych obejmujące różne etapy ścieżki zakupowej potencjalnych klientów. Dlaczego rosnąca konkurencyjność w organicznych wynikach wyszukiwania sprawia, że tradycyjne oczekiwania dotyczące czasu realizacji efektów pozycjonowania stają się nieaktualne w 2025 roku?

Proces pozycjonowania Twojej strony w Google nigdy nie będzie natychmiastowy

Efekty pozycjonowania stron internetowych manifestują się etapowo, począwszy od poprawy indeksowania oraz rozpoznawalności witryny przez algorytmy Google, poprzez wzrost pozycji dla długich fraz kluczowych o niższej konkurencyjności, aż po osiągnięcie wysokich pozycji dla strategicznych słów kluczowych o wysokim potencjale ruchu. Pierwszym widocznym efektem skutecznego pozycjonowania strony internetowej jest zazwyczaj poprawa technicznej oceny witryny w Google Search Console, redukcja błędów indeksowania oraz wzrost liczby strony w Google uwzględnionych w indeksie wyszukiwarki.

W 2025 roku proces pozycjonowania strony będzie dynamiczny

Współczesne pozycjonowanie stron www charakteryzuje się większą nieprzewidywalnością czasową ze względu na częste aktualizacje algorytmów Google oraz rosnącą konkurencję w większości branż, co oznacza, że nawet doskonale zaplanowana strategia pozycjonowania może wymagać korekt oraz dostosowań w trakcie realizacji. Prymarne znaczenie ma systematyczność działań oraz cierpliwość, gdyż pozycjonowanie stron internetowych jest procesem budowania długoterminowej przewagi konkurencyjnej, a nie szybkim sposobem na osiągnięcie natychmiastowych rezultatów.

Działania optymalizacyjne powinny być wieloletnie i nieustanne

Monitorowanie postępów w pozycjonowaniu stron wymaga wykorzystania odpowiednich narzędzi analitycznych oraz koncentracji na długoterminowych trendach zamiast uwzględniania krótkoterminowych fluktuacji pozycji, które są naturalnym elementem dynamiki wyników wyszukiwania. Ważne jest również zrozumienie, że efekty pozycjonowania stron internetowych kumulują się w czasie, co oznacza, że inwestycja w SEO w pierwszym roku może przynosić korzyści przez wiele kolejnych lat, pod warunkiem kontynuacji działań optymalizacyjnych oraz adaptacji do zmieniających się algorytmów wyszukiwarek.

Dlaczego pozycjonowanie stron www powinno być integralną częścią strategii marketingowej?

Współczesny marketing cyfrowy wymaga holistycznego podejścia, w jakim pozycjonowanie stron internetowych funkcjonuje jako fundamentalny element ekosystemu promocyjnego, wspierający i wzmacniający efektywność wszystkich innych kanałów marketingowych poprzez budowanie organicznej widoczności oraz długoterminowego autorytetu marki w wyszukiwarce Google. Integracja pozycjonowania stron www ze strategią marketingową umożliwia synergię między różnymi działaniami promocyjnymi, od content marketingu po kampanie płatne, tworząc spójny obraz marki w organicznych wynikach wyszukiwania oraz maksymalizując zwrot z inwestycji w działania marketingowe. Jak fragmentaryczne podejście do pozycjonowania stron internetowych może sabotować skuteczność całej strategii marketingowej oraz prowadzić do marnotrawstwa budżetu promocyjnego?

Pozycjonowanie stron www powinno być integralną częścią strategii marketingowej, ponieważ pozwala na:

- budowanie długoterminowej przewagi konkurencyjnej – pozycjonowanie stron www tworzy trwałe fundamenty widoczności online, które są trudne do skopiowania przez konkurencję oraz generują wartość przez wiele lat,

- maksymalizacja efektywności budżetu marketingowego – organiczny ruch z pozycjonowania stron internetowych charakteryzuje się niższym kosztem pozyskania klienta w porównaniu do kampanii płatnych,

- poprawa wiarygodności marki – wysokie pozycje w naturalnych wynikach wyszukiwania zwiększają zaufanie potencjalnych klientów oraz postrzeganie autorytetu marki w branży,

- synergia z innymi kanałami marketingowymi – skuteczne pozycjonowanie strony internetowej wspiera efektywność: kampanii płatnych, marketingu elektronicznego oraz działań w mediach społecznościowych,

- uniezależnienie od zmian w platformach płatnych – organiczna widoczność zapewnia stabilność ruchu niezależnie od zmian w algorytmach reklamowych czy wzrostu kosztów kampanii płatnych,

- wsparcie procesu podejmowania decyzji zakupowych – pozycjonowanie dla różnorodnych fraz kluczowych umożliwia dotarcie do potencjalnych klientów na wszystkich etapach ścieżki zakupowej,

- zwiększenie efektywności konwersji – użytkownicy pochodzący z organicznych wyników wyszukiwania charakteryzują się wyższymi współczynnikami konwersji oraz wartością transakcji.

Strategiczne podejście do pozycjonowania stron internetowych jako elementu szerszej strategii marketingowej wymaga koordynacji między różnymi działami oraz kanałami promocyjnymi, co zapewnia spójność komunikacji oraz maksymalizację synergii między poszczególnymi inicjatywami. Współczesne przedsiębiorstwa, które traktują pozycjonowanie stron www jako izolowane działanie, tracą znaczący potencjał biznesowy oraz konkurencyjne możliwości, wynikające z integracji SEO z całościową strategią marketingową.

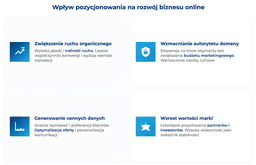

Jak pozycjonowanie stron wpływa na rozwój biznesu online?

Pozycjonowanie stron internetowych stanowi katalizator rozwoju biznesu online, generując stały strumień potencjalnych klientów poprzez organiczne wyniki wyszukiwania oraz budując długoterminowy autorytet marki, który przekłada się na zwiększenie rozpoznawalności, zaufania oraz ostatecznie – przychodów przedsiębiorstwa działającego w środowisku cyfrowym. Skuteczne pozycjonowanie strony internetowej wpływa na wszystkie najistotniejsze wskaźniki biznesowe, od liczby potencjalnych klientów i konwersji po wartość życiową klienta oraz przewagę konkurencyjną w branży, tworząc solidne fundamenty dla skalowania działalności online oraz ekspansji na nowe rynki. Jak wymierne korzyści pozycjonowania stron www na kluczowe wskaźniki biznesowe może uzasadnić długoterminowe inwestycje w strategię SEO jako fundamentalny element wzrostu przedsiębiorstwa?

Zwiększenie ruchu organicznego na stronie

Bezpośredni wpływ pozycjonowania stron internetowych na rozwój biznesu manifestuje się poprzez systematyczne zwiększanie organicznego ruchu na stronie, który charakteryzuje się wysoką jakością oraz trafnością względem oferowanych produktów bądź usług, co przekłada się na lepsze współczynniki konwersji oraz wyższą wartość średniej transakcji w porównaniu do innych źródeł ruchu. Efekty pozycjonowania stron internetowych kumulują się w czasie, tworząc efekt narastający, w którym każdy miesiąc systematycznych działań SEO przynosi coraz większe korzyści biznesowe oraz umacnia pozycję konkurencyjną w organicznych wynikach wyszukiwania.

Wzmacnianie autorytetu domeny

Pozycjonowanie stron www wspiera również rozwój biznesu poprzez umożliwienie ekspansji na nowe segmenty rynku oraz geograficzne rynki bez konieczności proporcjonalnego zwiększania budżetu marketingowego, co jest szczególnie istotne dla pozycjonowania sklepów internetowych dążących do skalowania biznesu. Długoterminowa strategia pozycjonowania tworzy również wartościowe zasoby cyfrowe w postaci wysoko pozycjonowanych treści oraz autorytetu domeny, które mogą być wykorzystywane do wsparcia wprowadzania nowych produktów oraz usług.

Wzrost wartości marki i pozyskiwanie partnerów biznesowych

Współczesne pozycjonowanie stron internetowych wspiera rozwój biznesu online również poprzez generowanie cennych danych o zachowaniach oraz preferencjach potencjalnych klientów Twojej witryny, jakie da się wykorzystywać do: optymalizacji oferty, personalizacji komunikacji oraz podejmowania strategicznych decyzji biznesowych opartych na rzeczywistych potrzebach klientów i rynku. Dodatkowo, silna pozycja w organicznych wynikach wyszukiwania zwiększa wartość marki oraz ułatwia pozyskiwanie partnerów biznesowych, inwestorów, a także talentów, postrzegających wysoką widoczność online jako wskaźnik stabilności oraz perspektyw rozwoju przedsiębiorstwa.

Jakie są najczęstsze wyzwania w pozycjonowaniu stron www w 2025 roku?

Współczesne pozycjonowanie stron internetowych napotyka na bezprecedensowe wyzwania wynikające z dynamicznych zmian w algorytmach Google, rosnącej konkurencji w organicznych wynikach wyszukiwania oraz ewolucji zachowań użytkowników, którzy coraz częściej korzystają z różnorodnych urządzeń, a przede wszystkim formatów wyszukiwania, od tradycyjnych zapytań tekstowych po wyszukiwanie głosowe oraz wizualne. Skuteczne pozycjonowanie strony internetowej w 2025 roku wymaga nie tylko doskonałej znajomości klasycznych technik SEO, ale również adaptacji do nowych technologii oraz zmieniających się oczekiwań użytkowników, redefiniujących sposób, w jaki algorytmy wyszukiwarek oceniają oraz rankują strony www w wynikach wyszukiwania. Dlaczego tradycyjne podejścia do pozycjonowania stron internetowych stają się niewystarczające w obliczu zakłóceń technologicznych oraz zwiększonej konkurencji charakteryzujących obecny krajobraz marketingu cyfrowego?

| Wyzwanie w pozycjonowaniu | Sposoby radzenia sobie | Główne korzyści rozwiązania | Dodatkowe uwagi |

|---|---|---|---|

| Intensywna konkurencja w wynikach wyszukiwania | – Koncentracja na długich frazach kluczowych. – Tworzenie wysoce spersonalizowanych treści. – Budowanie autorytetu w niszowych tematach. – Optymalizacja dla wyróżnionych fragmentów. | – Zwiększenie szans na wysokie pozycje. – Poprawa trafności ruchu. – Budowanie autorytetu w konkretnych segmentach. – Wyższe współczynniki konwersji. | – Wymaga głębokiej analizy konkurencji. – Konieczność ciągłego monitorowania zmian. – Długoterminowy charakter inwestycji. |

| Częste zmiany algorytmów Google | – Koncentracja na fundamentalnych zasadach SEO. – Dywersyfikacja strategii pozycjonowania. – Systematyczne monitorowanie wydajności. – Szybka adaptacja do zmian. | – Długoterminowa stabilność pozycji. – Redukcja ryzyka kar. – Lepsze przygotowanie na przyszłe zmiany. – Zwiększona odporność na fluktuacje. | – Wymaga stałej edukacji zespołu. – Konieczność elastyczności w strategii. – Potrzeba zaawansowanych narzędzi monitoringu mediów. |

| Rosnące oczekiwania dotyczące podstawowych wskaźników wydajności | – Optymalizacja infrastruktury technicznej. – Implementacja nowoczesnych technologii internetowych. – Regularny audyt wydajności. – Priorytetyzacja doświadczeń użytkowników. | – Poprawa pozycji w wynikach wyszukiwania. – Zwiększenie satysfakcji użytkowników. – Wyższe współczynniki konwersji. – Przewaga konkurencyjna. | – Wysokie koszty optymalizacji technicznej. – Wymaga współpracy z programistami. – Ciągły monitoring wydajności. |

| Dominacja sztucznej inteligencji w wyszukiwaniu | – Optymalizacja dla generatywnych wyników wyszukiwania. – Tworzenie treści odpowiadających na bezpośrednie pytania. – Strukturyzacja danych dla lepszego zrozumienia przez algorytmy. – Koncentracja na ekspertyzie oraz autorytatywności. | – Lepsze pozycjonowanie w wynikach generowanych przez sztuczną inteligencję. – Zwiększona widoczność w wyszukiwaniu głosowym. – Poprawa trafności treści. – Przygotowanie strategii na przyszłość. | – Nieprzewidywalność rozwoju sztucznej inteligencji. – Konieczność ciągłego uczenia się. – Zmieniające się najlepsze praktyki. |

| Fragmentacja wyników wyszukiwania | – Optymalizacja dla różnych typów funkcji w wynikach wyszukiwania. – Tworzenie zróżnicowanych formatów treści. – Budowanie obecności w różnych kanałach. – Koncentracja na treściach, które realizować wiele intencji użytkownika (User Intent). | – Maksymalizacja widoczności w wynikach wyszukiwania. – Zwiększenie współczynników kliknięć. – Lepsze pokrycie różnych intencji użytkowników. – Dywersyfikacja źródeł ruchu. | – Kompleksowość strategii. – Wymaga specjalistycznej wiedzy. – Konieczność testowania różnych podejść. |

| Wyzwania związane z indeksowaniem mobilnym | – Pełna responsywność wszystkich elementów strony. – Optymalizacja dla doświadczeń użytkowników na urządzeniach mobilnych. – Szybkość ładowania na urządzeniach mobilnych. – Dostosowanie treści do konsumpcji mobilnej. | – Lepsze pozycje w wyszukiwaniu mobilnym. – Zwiększona dostępność dla użytkowników mobilnych. – Poprawa zaangażowania użytkowników. – Zgodność z wymaganiami Google. | – Wymaga przeprojektowania starszych witryn. – Koszty adaptacji mobilnej. – Ciągła optymalizacja doświadczeń użytkowników. |

Przezwyciężanie tych wyzwań w pozycjonowaniu stron internetowych wymaga strategicznego podejścia oraz inwestycji w ciągłe uczenie się oraz adaptację technologiczną, które umożliwiają utrzymanie konkurencyjnej pozycji w dynamicznie zmieniającym się środowisku SEO. Przedsiębiorstwa, które proaktywnie adresują te wyzwania, budują długoterminową przewagę konkurencyjną oraz lepiej przygotowują się na przyszłe zmiany w algorytmach wyszukiwarek oraz wzorcach zachowań użytkowników.

Jak pozycjonowanie stron internetowych zmienia się pod wpływem sztucznej inteligencji i nowych technologii?

Sztuczna inteligencja fundamentalnie przekształca krajobraz pozycjonowania stron internetowych, wprowadzając nowe paradygmaty w sposobie, w jaki algorytmy Google: analizują, interpretują oraz rankują treści w organicznych wynikach wyszukiwania, co wymaga ewolucji tradycyjnych strategii SEO w kierunku bardziej zaawansowanych podejść uwzględniających przetwarzanie języka naturalnego, wyszukiwanie semantyczne oraz treści generowane przez sztuczną inteligencję. Implementacja generatywnych doświadczeń wyszukiwania przez Google oraz rosnące znaczenie przeglądów generowanych przez sztuczną inteligencję w wynikach wyszukiwania oznacza, że skuteczne pozycjonowanie strony internetowej musi uwzględniać optymalizację pod kątem funkcji opartych na sztucznej inteligencji, które coraz bardziej dominują doświadczenia użytkowników w wyszukiwarce Google. Jak radykalne przemiany wynikające z adopcji sztucznej inteligencji wpływają na fundamentalne założenia dotyczące pozycjonowania stron www oraz jakie nowe możliwości powstają dla przedsiębiorstw gotowych się adaptować?

Sztuczna inteligencja umożliwia zastosowanie w tekście większej ilości słów kluczowych

Współczesne pozycjonowanie stron internetowych pod wpływem sztucznej inteligencji koncentruje się na tworzeniu treści, jakie nie tylko zawierają strategiczne słowa kluczowe, ale również demonstrują: autentyczną ekspertyzę, autorytatywność oraz wiarygodność, które są coraz skuteczniej rozpoznawane przez algorytmy Google oparte na sztucznej inteligencji poprzez zaawansowane zrozumienie języka naturalnego oraz analizę kontekstu. Content marketing w erze sztucznej inteligencji wymaga większego skupienia na trafności semantycznej oraz kompleksowym pokryciu tematów, gdyż algorytmy uczenia maszynowego lepiej rozumieją relacje między pojęciami oraz intencje użytkowników stojące za zapytaniami wyszukiwania.

Pozycjonowanie stron internetowych musi być dostosowane do wyszukiwania głosowego oraz konwersacyjnej odsłony sztucznej inteligencji

Wyszukiwanie głosowe oraz konwersacyjna sztuczna inteligencja fundamentalnie zmieniają sposób, w jaki użytkownicy formułują zapytania wyszukiwania, co oznacza, że skuteczne pozycjonowanie stron www musi uwzględniać optymalizację dla zapytań w języku naturalnym oraz wyszukiwań opartych na pytaniach, które często znacząco różnią się od tradycyjnych wzorców wyszukiwania opartych na słowach kluczowych. Pozycjonowanie stron internetowych w kontekście sztucznej inteligencji wymaga również optymalizacji dla wyróżnionych fragmentów oraz innych funkcji wyników wyszukiwania wspieranych przez sztuczną inteligencję, które coraz bardziej dominują wyniki pierwszej strony, a także przechwytują znaczną część ruchu wyszukiwania.

Odejście od uniwersalnych rankingów na rzecz spersonalizowanych doświadczeń użytkowników

Nowe technologie, takie jak: wyszukiwanie wizualne, wyszukiwanie w rzeczywistości rozszerzonej oraz zapytania oparte na urządzeniach internetowych tworzą nowe obszary dla pozycjonowania stron internetowych, wymagając ekspansji poza tradycyjną optymalizację tekstową w kierunku strategii treści wielomodalnych oraz implementacji technicznych, wspierających różnorodne modalności wyszukiwania. Personalizacja oparta na sztucznej inteligencji w wynikach wyszukiwania oznacza również, że pozycjonowanie stron www musi uwzględniać większą zmienność w wynikach dla różnych użytkowników oraz optymalizować pod kątem spersonalizowanych doświadczeń wyszukiwania zamiast uniwersalnych rankingów.

Sztuczna inteligencja w pozycjonowaniu stron internetowych to nie tylko nowe narzędzie, ale fundamentalna zmiana sposobu myślenia o SEO, gdzie tradycyjne techniki optymalizacji ustępują miejsca strategiom opartym na głębokim zrozumieniu użytkowników oraz semantycznej trafności treści. Algorytmy sztucznej inteligencji Google coraz lepiej rozumieją kontekst, a przede wszystkim intencje, co oznacza, że skuteczne pozycjonowanie strony internetowej wymaga koncentracji na dostarczaniu autentycznej wartości zamiast manipulowania czynnikami rankingowymi. Przyszłość pozycjonowania stron www należy do przedsiębiorstw, które potrafią połączyć ludzką kreatywność z informacjami opartymi na sztucznej inteligencji, tworząc strategie treści, będących jednocześnie zoptymalizowanymi dla algorytmów oraz autentycznie użytecznymi dla użytkowników poszukujących informacji w wyszukiwarce Google.

Borys Bednarek, Head of SEO & TL Performance Marketing

Jakie trendy w pozycjonowaniu www będą dominować w najbliższych latach?

Najbliższe lata w pozycjonowaniu stron internetowych będą charakteryzować się: przyspieszoną adaptacją technologii sztucznej inteligencji, większym naciskiem na wskaźniki doświadczeń użytkowników oraz rosnącym znaczeniem sygnałów autorytatywności oraz ekspertyzy, które będą determinować sukces w organicznych wynikach wyszukiwania Google w niespotykanym dotąd stopniu. Trendy w pozycjonowaniu stron www ewoluują w kierunku bardziej holistycznych podejść, integrujących doskonałość techniczną z wysokiej jakości tworzeniem treści oraz zaawansowanym zrozumieniem wzorców zachowań użytkowników, szczególnie w kontekście korzystania z wielu urządzeń oraz zmieniających się nawyków wyszukiwania kreowanych przez asystentów głosowych oraz konsumpcję skoncentrowaną na urządzeniach mobilnych. Jak przewidywanie przyszłych trendów w pozycjonowaniu stron internetowych może umożliwić przedsiębiorstwom wczesną adopcję przewag konkurencyjnych oraz lepsze przygotowanie na nadchodzące zmiany w krajobrazie wyszukiwania?

Powstawanie nowych rankingów wyszukiwania

Personalizacja wyników wyszukiwania będzie odgrywać coraz ważniejszą rolę w pozycjonowaniu stron internetowych, co oznacza, że tradycyjne koncepty „jednej pozycji” dla wszystkich użytkowników będą stopniowo zastępowane przez dynamiczne, wrażliwe na kontekst rankingi, uwzględniające: historię użytkownika, lokalizację, typ urządzenia oraz inne czynniki personalizacji. Skuteczne pozycjonowanie strony internetowej będzie wymagać optymalizacji dla różnorodnych segmentów użytkowników oraz tworzenia treści, które dobrze sprawdzają się w różnych scenariuszach personalizacji.

Zwrócenie uwagi na kwestie ściśle związane z ekologią

Zrównoważony rozwój oraz względy środowiskowe będą coraz bardziej wpływać na pozycjonowanie stron www, gdyż Google większy nacisk kładzie na nagradzanie witryn, które demonstrują odpowiedzialność środowiskową poprzez zoptymalizowane zużycie energii, zrównoważone rozwiązania hostingowe oraz implementacje techniczne przyjazne środowisku. Zielone SEO stanie się ważnym wyróżnikiem konkurencyjnym, szczególnie dla marek kierujących się do świadomych ekologicznie konsumentów oraz branż, gdzie zrównoważony rozwój jest najważniejszym czynnikiem zakupowym.

Wykorzystanie coraz bardziej zaawansowanych narzędzi SEO

Optymalizacja treści w czasie rzeczywistym wspierana przez sztuczną inteligencję oraz uczenie maszynowe zrewolucjonizuje sposób, w jaki przedsiębiorstwa podchodzą do pozycjonowania stron internetowych, umożliwiając dynamiczne dostosowywanie treści, znaczników oraz innych elementów SEO na podstawie bieżących: trendów wyszukiwania, wzorców zachowań użytkowników oraz zmian w krajobrazie konkurencyjnym. Zautomatyzowane narzędzia SEO będą coraz bardziej zaawansowane, ale ludzkie myślenie strategiczne oraz kreatywność pozostaną niezbędne dla skutecznego pozycjonowania stron www.

Wykorzystanie innych kanałów marketingu cyfrowego

Integracja między SEO oraz innymi kanałami marketingu cyfrowego stanie się jeszcze bardziej płynna, z pozycjonowaniem stron internetowych służącym jako fundament dla kompleksowych strategii cyfrowych, które wykorzystują synergię między: wyszukiwaniem organicznym, reklamą płatną, marketingiem w mediach społecznościowych oraz kampaniami elektronicznymi. Ujednolicone podejścia marketingowe będą niezbędne dla maksymalizacji zwrotu z inwestycji oraz osiągnięcia trwałych przewag konkurencyjnych na coraz bardziej zatłoczonym rynku cyfrowym.

Jak mierzyć efekty pozycjonowania stron internetowych?

Systematyczny monitoring efektów pozycjonowania stron internetowych wymaga wykorzystania kompleksowego zestawu metryk oraz wskaźników, zapewniających holistyczny obraz wydajności kampanii SEO oraz umożliwiających podejmowanie decyzji opartych na danych w kontekście strategii optymalizacji, jak również alokacji zasobów dla długoterminowego sukcesu w organicznych wynikach wyszukiwania. Skuteczne mierzenie efektów pozycjonowania strony internetowej wykracza daleko poza proste śledzenie rankingów, obejmując: wskaźniki zaangażowania użytkowników, współczynniki konwersji, wskaźniki wydajności technicznej oraz pomiary wpływu biznesowego, które wspólnie determinują zwrot z inwestycji SEO oraz kierują przyszłymi decyzjami strategicznymi.

Aby efektywnie mierzyć pozycjonowanie stron internetowych, należy mieć na uwadze następujące aspekty:

- analiza pozycji w wynikach wyszukiwania – systematyczne śledzenie rankingów dla strategicznych słów kluczowych w Google Search Console oraz specjalistycznych narzędziach SEO, z uwzględnieniem fluktuacji oraz długoterminowych trendów,

- audyt ruchu organicznego – kompleksowa analiza wzorców ruchu organicznego, włączając: objętość, jakość, źródłowe słowa kluczowe oraz wskaźniki zachowań użytkowników zebrane przez Google Analytics,

- monitoring współczynników konwersji – śledzenie współczynników konwersji dla: segmentów ruchu organicznego, mierzenie realizacji celów oraz wydajności handlu elektronicznego przypisanej do działań SEO,

- ocena technicznej kondycji strony – regularna ocena podstawowych: wskaźników wydajności, szybkości strony, przyjazności mobilnej oraz innych czynników technicznych wpływających na wydajność wyszukiwania,

- pomiar udziału w głosie – obliczanie udziału w głosie w organicznych wynikach wyszukiwania dla istotnych słów kluczowych w branży oraz analiza krajobrazu konkurencyjnego,

- śledzenie budowania autorytetu – monitorowanie wzrostu autorytetu domeny, pozyskiwania linków zewnętrznych, wzrostu wzmianek o marce oraz innych wskaźników budowania autorytetu,

- analiza zaangażowania użytkowników – analiza wskaźników zaangażowania użytkowników, włączając: czas na stronie, strony na sesję, współczynnik odrzuceń oraz inne wskaźniki behawioralne.

Kompleksowe mierzenie strategii pozycjonowania stron internetowych wymaga integracji wielu źródeł danych oraz platform analitycznych, tworząc ujednolicony panel, umożliwiający szybką identyfikację trendów wydajności oraz obszarów wymagających natychmiastowej uwagi bądź działań optymalizacyjnych. Nowoczesne podejścia do mierzenia SEO wykorzystują analitykę predykcyjną oraz uczenie maszynowe do prognozowania przyszłych trendów wydajności, a ponadto identyfikacji możliwości optymalizacji zanim staną się krytycznymi problemami.

Skuteczne mierzenie pozycjonowania stron www obejmuje również porównanie konkurencyjne oraz analizę udziału w rynku, które zapewniają kontekst dla indywidualnych wskaźników wydajności, a przede wszystkim pomagają identyfikować trendy branżowe, jakie mogą wpłynąć na długoterminowy sukces strategii SEO. Regularne raportowanie oraz komunikacja z interesariuszami zapewnia, że inwestycje w SEO są zgodne z szerszymi celami biznesowymi oraz demonstrują wyraźną wartość dla kierownictwa organizacyjnego oraz decydentów odpowiedzialnych za alokację budżetu marketingowego.

Jakie błędy najczęściej popełniane są w procesie pozycjonowania stron?

Analiza najczęstszych błędów popełnianych podczas pozycjonowania stron internetowych dostarcza cennych wniosków dotyczących powszechnych pułapek, które mogą znacząco podważyć wysiłki SEO oraz uniemożliwić przedsiębiorstwom osiągnięcie pożądanych pozycji w organicznych wynikach wyszukiwania Google, pomimo znacznych inwestycji w czas oraz zasoby poświęcone działaniom optymalizacyjnym. Zrozumienie tych błędów oraz ich konsekwencji umożliwia proaktywną prewencję oraz strategiczne planowanie, maksymalizujące szanse na skuteczne pozycjonowanie strony internetowej oraz zrównoważony długoterminowy wzrost widoczności w wyszukiwaniu organicznym. Jak pozornie drobne błędy w implementacji SEO mogą kaskadowo przekształcić się w poważne niepowodzenia dla ogólnej wydajności pozycjonowania stron www oraz pozycjonowania konkurencyjnego?

| Błąd w pozycjonowaniu | Sposoby rozwiązania | Korzyści z unikania błędu | Wyzwania implementacyjne |

|---|---|---|---|

| Nadużywanie słów kluczowych | – Naturalna integracja słów kluczowych. – Badanie semantycznych słów kluczowych. – Skupienie na intencjach użytkowników. – Priorytetyzacja jakości treści. | – Unikanie kar Google. – Poprawa doświadczeń użytkowników. – Lepsze wskaźniki zaangażowania. – Długoterminowa stabilność rankingów. | – Balansowanie optymalizacji z naturalnością. – Szkolenie twórców treści. – Monitorowanie gęstości słów kluczowych. – Opracowywanie wytycznych stylistycznych. |

| Ignorowanie optymalizacji mobilnej | – Implementacja responsywnego designu. – Podejście mobile-first. – Optymalizacja szybkości dla urządzeń mobilnych. – Projektowanie interfejsu użytkownika przyjaznego dotykowi. | – Lepsze rankingi w wyszukiwaniu mobilnym. – Poprawa doświadczeń użytkowników. – Wyższe współczynniki konwersji. – Przyszłościowa witryna. | – Wyzwania implementacyjne techniczne. – Ograniczenia projektowe. – Testowanie na różnych urządzeniach. – Złożoność optymalizacji wydajności. |

| Brak strategii content marketingu | – Kompleksowe planowanie treści. – Regularny harmonogram publikacji. – Rozwój klastrów tematycznych. – Tworzenie treści skoncentrowanych na użytkownikach. | – Poprawa autorytetu tematycznego. – Lepsze zaangażowanie użytkowników. – Zwiększony ruch organiczny. – Wzmocnione rozpoznanie marki. | – Wyzwania alokacji zasobów. – Spójność jakości treści. – Wymagane długoterminowe zaangażowanie. – Mierzenie zwrotu z inwestycji w treści. |

| Zaniedbywanie technicznego SEO | – Regularne audyty techniczne. – Optymalizacja podstawowych wskaźników wydajności. – Implementacja znaczników strukturalnych. – Poprawa architektury strony. | – Lepsze indeksowanie oraz crawlowanie. – Poprawa doświadczeń użytkowników. – Wyższe rankingi w wyszukiwaniu. – Redukcja barier technicznych. | – Wymagania ekspertyzy technicznej. – Potrzebne zasoby deweloperskie. – Ciągła konserwacja. – Złożone rozwiązywanie problemów. |

| Nieprawidłowe linkowanie wewnętrzne | – Strategiczne planowanie linków wewnętrznych. – Linkowanie kontekstowe. – Optymalizacja tekstów kotwic. – Poprawa struktury strony. | – Lepsza dystrybucja autorytetu stron. – Poprawa nawigacji użytkowników. – Zwiększona efektywność crawlowania. – Silniejsze relacje tematyczne. | – Wymagania audytu treści. – Planowanie struktury linków. – Ciągła konserwacja. – Balansowanie SEO z doświadczeniami użytkowników. |

| Brak monitoringu konkurencji | – Regularna analiza konkurencyjna. – Monitorowanie funkcji wyników wyszukiwania. – Identyfikacja luk w treści. – Porównanie strategii. | – Inteligencja konkurencyjna. – Identyfikacja możliwości rynkowych. – Udoskonalenie strategii. – Proaktywna adaptacja. | – Czasochłonna analiza. – Inwestycja w narzędzia. – Wyzwania interpretacyjne. – Pozostawanie na bieżąco. |

| Krótkoterminowe myślenie | – Rozwój długoterminowej strategii. – Zrównoważone praktyki optymalizacji. – Nastawienie na ciągłe doskonalenie. – Podejście cierpliwej inwestycji. | – Zrównoważone ulepszenia rankingów. – Zmniejszone ryzyko kar. – Lepszy zwrot z inwestycji długoterminowych. – Budowanie przewagi konkurencyjnej. | – Wyzwania akceptacji kierownictwa. – Trudności planowania zasobów. – Pomiar wyników. – Spójność strategii. |

Skuteczne unikanie tych powszechnych błędów wymaga kompleksowego zrozumienia najlepszych praktyk SEO oraz zaangażowania w ciągłe uczenie się oraz adaptację w szybko ewoluującym krajobrazie wyszukiwania, gdzie aktualizacje algorytmów oraz presje konkurencyjne nieustannie kwestionują tradycyjne podejścia do pozycjonowania stron internetowych. Organizacje, które proaktywnie adresują potencjalne pułapki poprzez systematyczne planowanie oraz środki kontroli jakości, znacząco zwiększają swoje szanse na osiągnięcie trwałego sukcesu w organicznych wynikach wyszukiwania oraz budowanie długoterminowych przewag konkurencyjnych.

FAQ

Formularz kontaktowy

Pozycjonowanie stron internetowych

Razem z całym zespołem Cyrek Digital pomagam firmom w cyfrowej transformacji. Specjalizuje się w technicznym SEO. Na działania marketingowe patrzę zawsze przez pryzmat biznesowy.

Oceń tekst

Być może zainteresują Cię: