Spis treści

- Uczenie głębokie – definicja

- Jak działa uczenie głębokie w praktyce?

- Jakie rodzaje sieci neuronowych są wykorzystywane w uczeniu głębokim?

- Czym różni się uczenie głębokie od uczenia maszynowego?

- Jak działa proces uczenia w modelach głębokiego uczenia?

- Jakie są praktyczne zastosowania uczenia głębokiego?

- Jakie są zalety i wyzwania związane z uczeniem głębokim?

- Jak będzie rozwijać się uczenie głębokie w najbliższych latach?

Uczenie głębokie – co to jest?

Komputery coraz częściej potrafią widzieć, słyszeć i rozumieć świat niczym ludzie. Analizują obrazy, tłumaczą języki, rozpoznają emocje i podejmują decyzje bez ludzkiej pomocy. Za tą zdolnością stoi uczenie głębokie – cicha siła napędowa sztucznej inteligencji, która zmieniła sposób, w jaki technologia uczy się i reaguje na nasz świat.

Z tego artykułu dowiesz się:

- Co to jest uczenie głębokie?

- Jak działa uczenie głębokie w praktyce?

- Jakie rodzaje sieci neuronowych są wykorzystywane w uczeniu głębokim?

- Czym różni się uczenie głębokie od uczenia maszynowego?

- Jak działa proces uczenia w modelach głębokiego uczenia?

- Jakie są praktyczne zastosowania uczenia głębokiego?

- Jakie są zalety i wyzwania związane z uczeniem głębokim?

- Jak będzie się rozwijać uczenie głębokie w najbliższych latach?

Najważniejsze informacje:

- Uczenie głębokie (deep learning) to zaawansowany rodzaj uczenia maszynowego (machine learning) oparty na głębokich sieciach neuronowych.

- Modele deep learningu przetwarzają dane warstwa po warstwie, ucząc się hierarchicznie – od prostych po złożone wzorce.

- Splotowe sieci neuronowe (CNN) analizują obrazy, rekurencyjne sieci (RNN) przetwarzają dane sekwencyjne, a transformery odpowiadają za rozumienie języka naturalnego.

- Uczenie nadzorowane to najczęstszy sposób treningu – sieć uczy się, porównując wyniki z oczekiwanym rezultatem.

- Deep learning znajduje zastosowanie w rozpoznawaniu mowy i twarzy, analizie tekstu, systemach rekomendacji i generatywnej sztucznej inteligencji.

- Wymaga dużych ilości danych wejściowych, mocy obliczeniowej oraz transparentnych zasad działania, by ograniczyć ryzyko błędów i nadużyć.

Uczenie głębokie – definicja

Uczenie głębokie to jedna z najbardziej zaawansowanych dziedzin sztucznej inteligencji, pozwalająca maszynom samodzielnie analizować dane i wyciągać wnioski[1] [2] [3]. Zamiast programować każdy krok, twórcy uczą system, jak uczyć się samodzielnie – poprzez analizę wzorców i zależności ukrytych w ogromnych zbiorach danych[4] [5] [6].

Uczenie głębokie (ang. deep learning) to podzbiór uczenia maszynowego (machine learning), oparty na działaniu sztucznych sieci neuronowych, które naśladują sposób pracy ludzkiego mózgu.

Definicja uczenia głębokiego

Algorytmy deep learning potrafią rozpoznawać obrazy, analizować mowę, tłumaczyć tekst czy przewidywać zachowania użytkowników – bez potrzeby ręcznego wskazywania reguł[7]. W miarę przetwarzania coraz większej ilości danych sieci neuronowe „doskonalą się”, ucząc się samodzielnie rozpoznawać coraz bardziej złożone zależności[8] [9]. Dzięki temu modele uczenia głębokiego znajdują zastosowanie w niemal każdej branży – od medycyny, przez finanse, po marketing i przemysł.

Jak działa uczenie głębokie w praktyce?

Uczenie głębokie działa w oparciu o sieci neuronowe, przetwarzające dane w sposób zbliżony do tego, jak ludzki mózg interpretuje bodźce. Taka sieć składa się z warstw: wejściowej, która przyjmuje dane (np. obraz lub tekst), ukrytych, które analizują i przekształcają informacje oraz warstwy wyjściowej, generującej końcowy wynik. Każdy neuron przekazuje sygnał dalej, a model dzięki temu stopniowo uczy się rozpoznawać wzorce i zależności.

W uproszczeniu – im więcej warstw ma sieć i im więcej danych analizuje, tym „głębiej” potrafi zrozumieć problem. Dlatego właśnie deep learning jest tak skuteczny w zadaniach, które wymagają rozpoznawania skomplikowanych struktur, takich jak obrazy, dźwięki czy język naturalny. W miarę treningu sieć samodzielnie koryguje swoje błędy, dopasowując parametry, by uzyskiwać coraz trafniejsze wyniki – to proces zwany uczeniem nadzorowanym.

Jakie rodzaje sieci neuronowych są wykorzystywane w uczeniu głębokim?

Uczenie głębokie obejmuje wiele architektur sieci neuronowych, z których każda została stworzona do określonych zadań – od analizy obrazu po rozumienie języka. To właśnie różnorodność tych modeli sprawia, że deep learning znajduje zastosowanie w tak wielu dziedzinach.

Splotowe sieci neuronowe (CNN, Convolutional Neural Networks)

Splotowe sieci neuronowe są jednym z filarów współczesnej sztucznej inteligencji. Wykorzystuje się je głównie do rozpoznawania obrazów, obiektów i wzorców wizualnych. Ich struktura przypomina sposób, w jaki ludzki wzrok analizuje otoczenie – warstwa po warstwie. CNN składają się z tzw. warstw konwolucyjnych, które filtrują obraz, wykrywając istotne cechy: krawędzie, kolory, kształty czy tekstury. W miarę przetwarzania sieć łączy te elementy w coraz bardziej złożone struktury – np. twarz, samochód czy logo marki. To właśnie CNN stoją za technologiami umożliwiającymi rozpoznawanie twarzy w smartfonach, analizę zdjęć medycznych, a nawet systemy wspomagające autonomiczne pojazdy.

Rekurencyjne sieci neuronowe (RNN, Recurrent Neural Networks)

Rekurencyjne sieci neuronowe zostały zaprojektowane do pracy z danymi sekwencyjnymi, czyli takimi, które mają znaczenie w określonym porządku – jak tekst, dźwięk czy dane czasowe. W odróżnieniu od CNN, RNN potrafią „zapamiętywać” wcześniejsze informacje i odnosić się do nich w kolejnych krokach przetwarzania. Dzięki temu świetnie sprawdzają się w analizie języka naturalnego, rozpoznawaniu mowy i prognozowaniu trendów finansowych. Ich nowsze warianty, takie jak LSTM (Long Short-Term Memory) czy GRU (Gated Recurrent Unit), zostały opracowane po to, by skuteczniej radzić sobie z długimi sekwencjami danych i uniknąć utraty kontekstu.

Sieci transformacyjne (Transformers)

Transformery to najnowsza i najbardziej zaawansowana forma sieci neuronowych, która całkowicie odmieniła przetwarzanie języka naturalnego (Natural Language Processing – NLP). Kluczowym elementem ich działania jest mechanizm self-attention, który pozwala analizować kontekst słów nie tylko względem ich kolejności, ale całego zdania czy akapitu. Dzięki temu modele oparte na tej architekturze potrafią rozumieć sens tekstu, generować odpowiedzi, tłumaczyć języki i streszczać treści w sposób zbliżony do ludzkiego myślenia. Transformery stanowią podstawę najpotężniejszych modeli językowych, takich jak GPT (Generative Pre-trained Transformer) czy BERT (Bidirectional Encoder Representations from Transformers), wykorzystywanych m.in. w wyszukiwarkach, chatbotach i systemach analitycznych.

Każdy z tych typów sieci neuronowych pełni inną funkcję, ale wszystkie łączy jeden cel: nauczyć maszyny rozpoznawać wzorce, rozumieć dane i wyciągać wnioski w sposób zbliżony do ludzkiego. Wspólnie tworzą one fundament współczesnej sztucznej inteligencji.

Czym różni się uczenie głębokie od uczenia maszynowego?

Choć pojęcia machine learning (uczenie maszynowe) i deep learning (uczenie głębokie) często są używane zamiennie, w rzeczywistości nie oznaczają tego samego. Uczenie głębokie jest podzbiorem uczenia maszynowego, który wykorzystuje złożone, wielowarstwowe sieci neuronowe do analizy danych i podejmowania decyzji.

Tradycyjne uczenie maszynowe polega na tym, że człowiek musi przygotować zestaw cech (tzw. feature engineering), które model wykorzysta do nauki. W praktyce oznacza to, że programista lub analityk wskazuje, które dane mają znaczenie dla wyniku, np. wiek, lokalizacja czy historia zakupów. W przypadku uczenia głębokiego ten etap zostaje zautomatyzowany. Sieć neuronowa sama „odkrywa” istotne wzorce i relacje w danych, ucząc się ich hierarchicznie – od prostych zależności po bardzo złożone struktury.

Różnice widoczne są także w skali i możliwościach. Uczenie maszynowe doskonale sprawdza się przy prostszych problemach i mniejszych zbiorach danych, natomiast uczenie głębokie potrzebuje ogromnych ilości informacji i mocy obliczeniowej, ale w zamian osiąga dużo wyższą dokładność i lepiej radzi sobie z danymi nieustrukturyzowanymi, jak obrazy, dźwięki czy tekst.

W praktyce oba podejścia się uzupełniają. Uczenie maszynowe stanowi solidną podstawę dla analizy danych i predykcji, podczas gdy uczenie głębokie otwiera drogę do zaawansowanych zastosowań, takich jak rozpoznawanie mowy, tłumaczenia maszynowe, asystenci cyfrowi czy generatywna sztuczna inteligencja.

Jak działa proces uczenia w modelach głębokiego uczenia?

Uczenie głębokie opiera się na koncepcji wielowarstwowych sieci neuronowych, które przetwarzają dane krok po kroku, przechodząc od prostych do coraz bardziej złożonych reprezentacji informacji. Każda warstwa sieci analizuje inny aspekt danych – np. w obrazie może to być najpierw krawędź, potem kształt, a ostatecznie całe obiekty.

Proces uczenia zaczyna się od danych wejściowych, które są przekazywane przez kolejne warstwy neuronów. Każdy neuron dokonuje prostych obliczeń, przypisując wagę poszczególnym elementom i przesyłając wynik dalej. W miarę przechodzenia przez kolejne warstwy, sieć tworzy coraz bardziej abstrakcyjne zrozumienie danych – od prostych wzorców po skomplikowane relacje.

Ważnym elementem jest tzw. propagacja wsteczna (backpropagation), czyli mechanizm pozwalający sieci „uczyć się na błędach”. Po wygenerowaniu wyniku model porównuje go z oczekiwanym rezultatem, oblicza różnicę (błąd) i dostosowuje wagi neuronów, by w kolejnych iteracjach poprawić dokładność. Proces ten powtarzany jest tysiące, a czasem miliony razy, aż model osiągnie zadowalającą skuteczność.

Do skutecznego działania modele głębokiego uczenia potrzebują dużych ilości danych oraz ogromnej mocy obliczeniowej, którą zapewniają nowoczesne procesory graficzne (GPU) i infrastruktura chmurowa. Dzięki temu mogą analizować miliardy przykładów i wykrywać wzorce, które dla człowieka byłyby niezauważalne.

W efekcie powstają modele zdolne do samodzielnego rozpoznawania, klasyfikowania i generowania informacji, co czyni z uczenia głębokiego jedno z najbardziej przełomowych osiągnięć w dziedzinie sztucznej inteligencji.

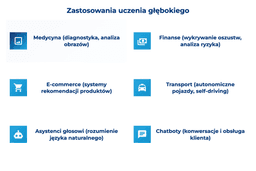

Jakie są praktyczne zastosowania uczenia głębokiego?

Uczenie głębokie stało się jednym z najpotężniejszych narzędzi współczesnej technologii. Dzięki zdolności analizy ogromnych ilości danych i samodzielnego „uczenia się” zależności, znajduje zastosowanie w niemal każdej branży: od medycyny, przez finanse, aż po marketing i transport.

W medycynie algorytmy deep learningu analizują obrazy rentgenowskie, tomografię komputerową czy wyniki badań laboratoryjnych, pomagając w diagnostyce chorób i wczesnym wykrywaniu nowotworów. Sieci neuronowe są w stanie zauważyć subtelne wzorce, których ludzki wzrok mógłby nie dostrzec, co znacząco zwiększa skuteczność diagnoz.

W branży finansowej uczenie głębokie wspiera systemy wykrywania oszustw, analizowania ryzyka kredytowego oraz przewidywania zmian rynkowych. Modele oparte na deep learningu potrafią błyskawicznie przetwarzać dane transakcyjne i wykrywać nietypowe zachowania, minimalizując ryzyko strat.

W e-commerce i marketingu technologia ta odpowiada za systemy rekomendacji, które analizują zachowania użytkowników i podpowiadają im produkty dopasowane do preferencji. To właśnie dzięki deep learningowi platformy streamingowe, takie jak Netflix czy Amazon potrafią przewidywać, co użytkownik będzie chciał obejrzeć lub kupić.

W transporcie uczenie głębokie odgrywa kluczową rolę w rozwoju autonomicznych pojazdów. Systemy analizują dane z kamer, radarów i czujników, by podejmować decyzje w czasie rzeczywistym: od rozpoznawania znaków drogowych po reagowanie na nieprzewidziane sytuacje na drodze.

Nie można też zapomnieć o zastosowaniach w asystentach głosowych i chatbotach, które dzięki deep learningowi potrafią rozumieć język naturalny i prowadzić rozmowy coraz bliższe ludzkim.

Uczenie głębokie zrewolucjonizowało sposób, w jaki komputery przetwarzają informacje. Dzięki połączeniu dużych zbiorów danych i ogromnej mocy obliczeniowej, modele głębokiego uczenia potrafią nie tylko rozpoznawać wzorce, ale też uczyć się samodzielnie, bez ciągłej ingerencji człowieka. To sprawia, że technologia ta ma kluczowe znaczenie dla rozwoju systemów rekomendacji, przetwarzania języka naturalnego i analizy obrazu. W najbliższych latach kluczowym wyzwaniem będzie jednak uczynienie tych modeli bardziej przejrzystymi i energooszczędnymi.

Max Cyrek, CEO Cyrek Digital

Jakie są zalety i wyzwania związane z uczeniem głębokim?

Uczenie głębokie rewolucjonizuje technologię, ale nie jest wolne od ograniczeń. Jego siłą jest zdolność do samodzielnego odkrywania zależności w danych, jednak wymaga to odpowiednich warunków i ogromnych zasobów.

Do największych zalet uczenia głębokiego należy jego precyzja i skuteczność. Modele deep learningu potrafią analizować nieustrukturyzowane dane – obrazy, teksty, dźwięki i dostarczać wyniki często dokładniejsze niż tradycyjne algorytmy. Są też niezwykle elastyczne, ponieważ można je dostosować do różnych zadań: od analizy sentymentu w mediach społecznościowych po przewidywanie zachowań konsumentów. W dodatku, w miarę gromadzenia nowych danych, modele te samodoskonalą się, stale podnosząc jakość wyników.

Z drugiej strony, głębokie uczenie niesie również wyzwania technologiczne i etyczne. Przede wszystkim wymaga ogromnych ilości danych treningowych i dużych mocy obliczeniowych, co wiąże się z wysokimi kosztami. Modele są też często trudne do interpretacji – choć potrafią działać skutecznie, nie zawsze wiadomo, jak dokładnie doszły do danego wniosku. To zjawisko określa się mianem czarnej skrzynki (ang. black box).

Istotnym problemem są również kwestie etyczne i prywatności danych. Sieci neuronowe uczą się na podstawie rzeczywistych informacji, co rodzi pytania o bezpieczeństwo i odpowiedzialność za decyzje podejmowane przez systemy AI.

Uczenie głębokie to potężne narzędzie, które łączy ogromny potencjał z realnymi wyzwaniami. Jego skuteczność zależy nie tylko od jakości danych i technologii, ale także od odpowiedzialnego podejścia do projektowania i wykorzystywania modeli sztucznej inteligencji.

Jak będzie rozwijać się uczenie głębokie w najbliższych latach?

Uczenie głębokie rozwija się w błyskawicznym tempie, a kierunek jego ewolucji wyznaczają rosnące potrzeby biznesu, nauki i społeczeństwa. Największym celem badaczy jest dziś zwiększenie efektywności modeli – tak, aby osiągały wysoką dokładność przy mniejszym zapotrzebowaniu na dane i moc obliczeniową.

Jednym z głównych trendów jest rozwój uczenia samonadzorowanego (self-supervised learning), które pozwala modelom uczyć się bez konieczności ręcznego etykietowania danych. Dzięki temu proces staje się szybszy, tańszy i bardziej skalowalny. Równolegle rozwija się uczenie transferowe (transfer learning), umożliwiające wykorzystywanie wiedzy zdobytej przez jeden model w nowych kontekstach – to rozwiązanie szczególnie popularne w firmach, które chcą wdrażać AI przy ograniczonych zasobach.

Coraz większe znaczenie zyskuje też AI generatywna, której podstawą są modele głębokiego uczenia zdolne do tworzenia tekstów, obrazów, muzyki czy kodu. Narzędzia oparte na deep learningu, takie jak ChatGPT, Midjourney czy Sora, pokazują, że granica między człowiekiem a maszyną w zakresie kreatywności staje się coraz bardziej płynna.

Kierunkiem, który zyskuje na znaczeniu, jest również explainable AI (XAI) – dziedzina zajmująca się tym, by modele uczenia głębokiego były bardziej przejrzyste i zrozumiałe. W dobie rosnącej roli sztucznej inteligencji w medycynie, finansach i administracji, zrozumienie mechanizmów podejmowania decyzji przez AI staje się kluczowe dla zaufania społecznego.

W perspektywie najbliższych lat możemy spodziewać się również integracji uczenia głębokiego z robotyką, Internetem Rzeczy (IoT) i rozszerzoną rzeczywistością (AR), co otworzy nowe możliwości w automatyzacji procesów i analizie danych w czasie rzeczywistym.

Przyszłość deep learningu to nie tylko większa moc obliczeniowa, ale też większa świadomość etyczna i transparentność działania modeli, które coraz mocniej wchodzą w codzienne życie i biznes.

FAQ

Przypisy

Formularz kontaktowy

Rozwijaj swoją firmę

Zajmuje się copywritingiem od 2020 roku, zaś pisaniem od 2010, co znalazło swój wyraz w jednej powieści, trzech książkach poetyckich i kilkudziesięciu artykułach opublikowanych w różnych mediach. Interesuje się content writinigiem, storytellingiem i rolą narzędzi AI we współczesnym copywritingu.

Oceń tekst

Być może zainteresują Cię: