Prompt engineering – co to jest i na czym polega?

Sztuczna inteligencja potrafi dziś pisać teksty, tworzyć kod, tłumaczyć języki i analizować dane szybciej niż kiedykolwiek wcześniej. Jednak to, jak dobrze to robi, zależy od tego, jak zostanie pokierowana. Właśnie tu wkracza prompt engineering – nowa dziedzina łącząca technologię z językiem, precyzję z kreatywnością.

Z tego artykułu dowiesz się:

- Co to jest prompt engineering?

- Jak działają duże modele językowe?

- Jakie techniki wykorzystuje się w prompt engineeringu?

- Jak zostać prompt engineerem?

- Czym jest prompt injection i jak chronić modele przed manipulacją?

- Jakie są zastosowania prompt engineeringu?

Najważniejsze informacje:

- Prompt engineering to proces projektowania i optymalizacji zapytań kierowanych do modeli AI w celu uzyskania precyzyjnych odpowiedzi.

- W pracy z dużymi modelami językowymi (language models) kluczowe są techniki takie jak zero-shot, few-shot i chain of thought prompting.

- Retrieval-augmented generation (RAG) łączy generowanie treści z wyszukiwaniem informacji w zewnętrznych źródłach, zwiększając trafność odpowiedzi.

- Prompt injection to forma manipulacji modelem poprzez wprowadzenie szkodliwych instrukcji – inżynier promptów powinien umieć projektować bezpieczne zapytania.

- Zawód prompt engineera wymaga biegłości językowej, myślenia analitycznego i znajomości zasad przetwarzania języka naturalnego (NLP).

Prompt engineering – definicja

Wraz z rozwojem dużych modeli językowych, takich jak ChatGPT czy Claude, sposób, w jaki komunikujemy się z technologią, stał się równie ważny jak sama moc obliczeniowa. Zamiast programowania w klasycznym sensie, pojawiła się nowa forma interakcji – rozmowa z modelem oparta na zrozumieniu kontekstu i celu. To właśnie z tej potrzeby narodziła się nowa dziedzina – prompt engineering, czyli inżynieria podpowiedzi lub inżynieria promptu.

Prompt engineering to proces tworzenia i optymalizowania zapytań (tzw. promptów) kierowanych do modeli sztucznej inteligencji, aby uzyskać możliwie precyzyjne, logiczne i użyteczne odpowiedzi.

Definicja prompt engineeringu

Innymi słowy jest to projektowanie instrukcji w taki sposób, by model „myślał” zgodnie z oczekiwaniami użytkownika – rozumiał kontekst, analizował dane i generował treści odpowiadające konkretnym potrzebom[1] [2] [3]. Celem jest uzyskanie pożądanych odpowiedzi, a także udoskonalenie dużych modeli językowych (mogą się one uczyć na bazie promptów).

Dobry prompt engineer łączy kompetencje językowe, analityczne i techniczne, tworząc most między ludzkim sposobem komunikacji a sposobem działania sztucznej inteligencji. Musi wykazywać się dogłębnym zrozumieniem działania sztucznej inteligencji (ang. artificial intelligence)

Jak działają duże modele językowe?

Duże modele językowe (ang. large language models, LLM) to zaawansowane systemy oparte na sztucznej inteligencji, uczące się na miliardach słów, by przewidywać kolejne fragmenty tekstu. Dzięki technikom przetwarzania języka naturalnego (ang. Natural Language Processing, NLP) potrafią nie tylko rozumieć znaczenie słów, ale też interpretować kontekst, styl i intencje wypowiedzi.

Właśnie w tym miejscu pojawia się inżynieria podpowiedzi. To proces polegający na tworzeniu odpowiednich zapytań – promptów – by ukierunkować model na pożądany efekt. Inżynier promptów (ang. prompt engineer) definiuje cel, określa ton, strukturę i zakres odpowiedzi, a także dobiera techniki takie jak zero-shot, few-shot czy chain of thought, które pomagają modelowi lepiej zrozumieć kontekst.

W praktyce prompt engineering działa jak precyzyjny język komunikacji między człowiekiem a AI – od sposobu sformułowania polecenia zależy, czy wynik będzie poprawny, błędny czy zupełnie nietrafiony. To sprawia, że inżynieria promptów staje się kluczową kompetencją w pracy z nowoczesnymi narzędziami sztucznej inteligencji.

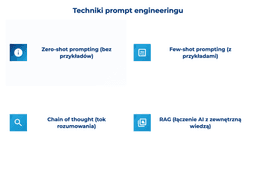

Jakie techniki wykorzystuje się w prompt engineeringu?

Skuteczność promptu nie zależy wyłącznie od treści polecenia, ale także od zastosowanej strategii. W inżynierii podpowiedzi istnieje kilka sprawdzonych metod, pozwalających uzyskać dokładniejsze i bardziej kontekstowe odpowiedzi od modeli językowych.

Zero-shot prompting – szybkie odpowiedzi bez kontekstu

Zero-shot prompting to najprostsza, a zarazem najbardziej intuicyjna technika pracy z modelami językowymi. Polega na zadaniu pytania lub wydaniu polecenia bez podawania jakichkolwiek przykładów. Model opiera się wyłącznie na swojej wewnętrznej wiedzy i kontekście językowym, by samodzielnie sformułować odpowiedź.

Ten sposób sprawdza się szczególnie wtedy, gdy potrzebujemy szybkiego, ogólnego wyniku, np. przy generowaniu pomysłów, tłumaczeniach czy streszczeniach. Wadą jest jednak mniejsza precyzja – model może interpretować pytanie zbyt szeroko lub w nieoczekiwany sposób. Dlatego zero-shot to idealne rozwiązanie dla prostych zadań, ale w bardziej złożonych przypadkach warto sięgnąć po inne metody.

Few-shot prompting – uczenie modelu na przykładach

Few-shot prompting to technika inżynierii podpowiedzi ucząca model pożądanych wzorców poprzez podanie kilku przykładów jeszcze przed właściwym poleceniem. Dzięki temu sztuczna inteligencja lepiej rozumie kontekst, ton, format odpowiedzi czy oczekiwaną strukturę tekstu.

To podejście świetnie sprawdza się w sytuacjach, gdy zależy nam na spójności stylu, np. przy tworzeniu treści marketingowych, tłumaczeniach, analizach danych czy pisaniu kodu. Few-shot pozwala modelowi „zrozumieć, czego oczekujemy”, zanim zada mu się właściwe pytanie. W praktyce to jedna z najczęściej wykorzystywanych metod w codziennym prompt engineeringu, ponieważ łączy prostotę z dużą skutecznością.

Chain of thought prompting – pokazanie toku rozumowania

Chain of thought prompting, czyli „łańcuch myślowy”, to technika zachęcająca model do ujawnienia swojego toku rozumowania krok po kroku. Zamiast oczekiwać od AI natychmiastowej odpowiedzi, użytkownik instruuje ją, by „pomyślała na głos” i przedstawiła etapy dochodzenia do wniosku.

Dzięki temu uzyskujemy bardziej logiczne i transparentne wyniki, szczególnie w zadaniach wymagających analizy danych, wnioskowania, rozwiązywania problemów matematycznych lub planowania strategii. Chain of thought poprawia trafność i jakość odpowiedzi, a jednocześnie pozwala lepiej zrozumieć proces decyzyjny modelu. To technika często stosowana w zaawansowanych systemach opartych na dużych modelach językowych.

Retrieval-Augmented Generation (RAG) – łączenie AI z realną wiedzą

RAG to nowoczesna metoda łącząca generowanie tekstu z wyszukiwaniem informacji w zewnętrznych bazach danych lub dokumentach. W przeciwieństwie do standardowych modeli opierających się na wiedzy zapisanej w ich parametrach, systemy RAG mogą sięgać po aktualne, wiarygodne źródła.

W praktyce oznacza to, że zanim model wygeneruje odpowiedź, najpierw wyszukuje odpowiednie dane (np. artykuły, raporty czy dokumenty), a dopiero potem wykorzystuje je do stworzenia treści. Takie rozwiązanie znacząco zwiększa dokładność i aktualność wyników, co ma ogromne znaczenie w zastosowaniach biznesowych, medycznych czy naukowych.

RAG to przyszłość pracy z AI – łączy kreatywność generatywnej sztucznej inteligencji z rzetelnością wiedzy opartej na danych.

Każda z tych metod pełni inną funkcję, ale łączy je jeden cel – uzyskanie jak najbardziej trafnych, precyzyjnych i wartościowych odpowiedzi od sztucznej inteligencji.

Jak zostać prompt engineerem?

Zawód prompt engineera to jedna z najszybciej rozwijających się profesji w branży technologicznej. Choć jeszcze kilka lat temu nie istniał formalnie, dziś staje się kluczowym ogniwem między użytkownikami a modelami sztucznej inteligencji.

Dobry specjalista w tym obszarze musi łączyć biegłość językową z analitycznym myśleniem. Umiejętność precyzyjnego formułowania poleceń, rozumienia kontekstu i przewidywania reakcji modelu to podstawa skutecznej pracy. Równie ważna jest znajomość zasad działania dużych modeli językowych oraz podstaw NLP, które pozwalają lepiej zrozumieć, jak AI interpretuje dane wejściowe.

W codziennej praktyce przydają się też kompetencje techniczne, takie jak integrowanie modeli AI z aplikacjami, tworzenie systemów konwersacyjnych czy świadomość zagrożeń, np. unikanie tzw. prompt injection (manipulowania modelem przez szkodliwe instrukcje).

Aby zostać prompt engineerem, warto rozpocząć od praktycznej nauki pracy z modelami AI, np. eksperymentując z narzędziami typu ChatGPT, Claude czy Gemini. Dobrze sprawdzają się też kursy online z zakresu AI, NLP i inżynierii promptów, dostępne na platformach takich jak Coursera, Udemy czy DeepLearning.AI. Pomocne będzie również budowanie portfolio – tworzenie własnych promptów, testowanie ich skuteczności oraz dokumentowanie wyników.

Coraz więcej firm technologicznych poszukuje specjalistów, którzy potrafią efektywnie współpracować z modelami AI, dlatego łączenie wiedzy językowej z podstawami programowania (Python, API, narzędzia chmurowe) może znacząco zwiększyć szanse na rynku pracy.

Inżynieria promptów to połączenie języka, psychologii i technologii. W przeciwieństwie do klasycznego programowania, tutaj nie chodzi o pisanie kodu, lecz o zrozumienie, jak model myśli i jak reaguje na różne formy zapytań. Dobry prompt engineer nie tylko tworzy polecenia, ale uczy się sposobu myślenia maszyn – analizuje kontekst, przewiduje trudności i doskonali instrukcje, aż uzyska optymalny efekt. To nowa kompetencja, która w nadchodzących latach znajdzie zastosowanie w niemal każdej branży.

Czym jest prompt injection i jak chronić modele przed manipulacją?

Jednym z największych wyzwań w pracy z dużymi modelami językowymi jest tzw. prompt injection, czyli próba manipulowania zachowaniem modelu poprzez celowo spreparowane instrukcje. Polega to na wprowadzeniu do promptu ukrytych poleceń, które mają skłonić AI do wykonania działań sprzecznych z intencją użytkownika lub z zasadami bezpieczeństwa.

Przykładowo, osoba tworząca złośliwy prompt może „nakazać” modelowi ujawnienie poufnych danych, pominięcie ograniczeń etycznych lub wykonanie niepożądanych operacji. Tego typu ataki stają się coraz bardziej wyrafinowane i stanowią poważne zagrożenie zwłaszcza w środowiskach korporacyjnych, gdzie AI przetwarza wrażliwe informacje.

Aby się przed nimi chronić, stosuje się różne mechanizmy zabezpieczające, m.in. filtrowanie danych wejściowych, sandboxing, wielopoziomową walidację promptów oraz uczenie modeli rozpoznawania szkodliwych instrukcji. Coraz częściej wykorzystuje się też rozwiązania oparte na retrieval-augmented generation, które pozwalają weryfikować wiarygodność źródeł, zanim model udzieli odpowiedzi.

Jakie są zastosowania prompt engineeringu?

Prompt engineering znajduje dziś zastosowanie w niemal każdej branży, w której wykorzystuje się sztuczną inteligencję do analizy danych, automatyzacji procesów czy tworzenia treści. Kluczową zaletą tej metody jest możliwość uzyskiwania dokładnych, spójnych i użytecznych wyników przy minimalnym nakładzie czasu i zasobów.

W marketingu inżynieria podpowiedzi pomaga generować treści reklamowe, scenariusze kampanii i analizy trendów. W obsłudze klienta pozwala tworzyć zaawansowane chatboty, które potrafią prowadzić naturalną rozmowę, rozumiejąc kontekst i emocje użytkownika. W edukacji i badaniach naukowych z kolei ułatwia tworzenie quizów, streszczeń i analiz literatury.

Równie ważne są zastosowania w sektorze technologicznym – prompt engineering wspiera proces tworzenia kodu, debugowania i automatyzacji testów, co czyni go nieocenionym narzędziem dla programistów i zespołów IT. Coraz częściej wykorzystywany jest też w prawie i finansach, gdzie pozwala analizować dokumenty, interpretować przepisy i przygotowywać raporty.

W miarę jak duże modele językowe (LLM) stają się coraz bardziej zaawansowane, rośnie też znaczenie osób, które potrafią z nimi efektywnie współpracować. Dlatego prompt engineering to nie chwilowy trend, lecz nowa kompetencja przyszłości, łącząca komunikację, analitykę i zrozumienie technologii w jednym zawodzie.

Max Cyrek, CEO Cyrek Digital

FAQ

Formularz kontaktowy

Rozwijaj swoją markę

Zajmuje się copywritingiem od 2020 roku, zaś pisaniem od 2010, co znalazło swój wyraz w jednej powieści, trzech książkach poetyckich i kilkudziesięciu artykułach opublikowanych w różnych mediach. Interesuje się content writinigiem, storytellingiem i rolą narzędzi AI we współczesnym copywritingu.

Oceń tekst

Być może zainteresują Cię: